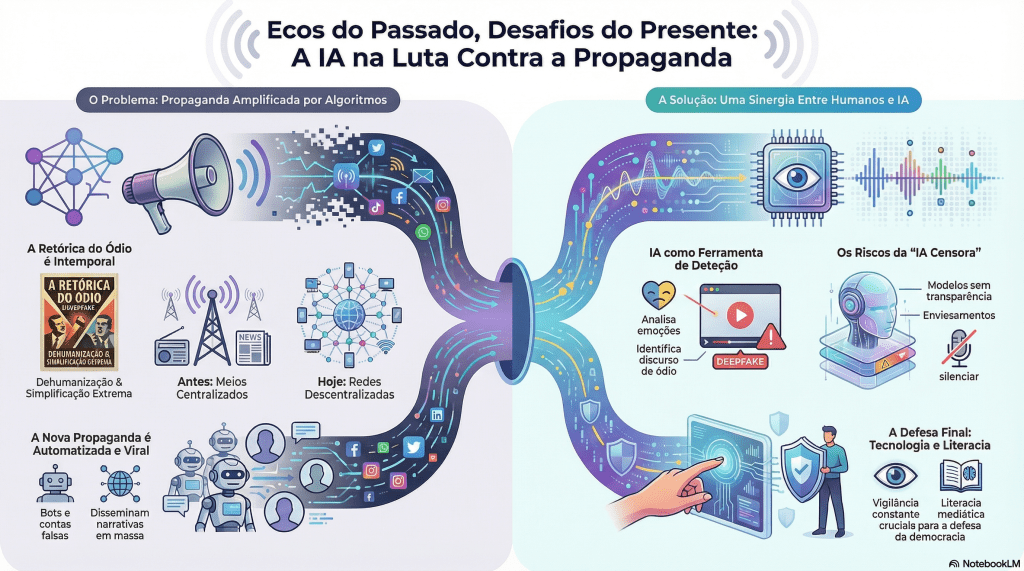

Este infográfico explora a dualidade da Inteligência Artificial no cenário da comunicação moderna. De um lado, vemos como algoritmos amplificam a propaganda antiga e o discurso de ódio. Do outro, como a mesma tecnologia pode ser usada para detectar deepfakes e proteger a democracia — desde que aliada à supervisão humana e à literacia digital para evitar a censura.

Este artigo propõe uma análise crítica da propaganda histórica, utilizando a propaganda nazi como estudo de caso, e explorando o papel da Inteligência Artificial (IA) na sua desconstrução e na deteção de conteúdo manipulador contemporâneo. A metodologia combina a análise retórica clássica com abordagens computacionais de Processamento de Linguagem Natural (PLN) e Machine Learning. O estudo foca-se em três eixos: 1) A identificação de padrões retóricos e figuras de linguagem (ex: desumanização, apelo ao pathos) através de modelos de IA; 2) A modelação da disseminação e do alcance da propaganda em diferentes meios (históricos e digitais); e 3) A investigação da eficácia da IA no desenvolvimento de contramedidas e na deteção automática de discurso de ódio e desinformação. Os resultados sublinham a continuidade dos padrões retóricos da propaganda histórica no ambiente digital e a urgência de uma sinergia Humano-IA para a literacia mediática e a prevenção da radicalização.

Palavras-Chave: Propaganda Nazi; Retórica; Inteligência Artificial; Análise de Discurso; Discurso de Ódio; Comunicação.

1. Introdução

A informação tornou-se um dos pilares fundamentais da vida contemporânea. A forma como circula, se produz e se consome determina perceções, molda opiniões, influencia comportamentos e, inevitavelmente, condiciona a saúde das democracias. No século XXI, a manipulação informacional deixou de depender de censura explícita ou de aparelhos propagandísticos centralizados, como aqueles utilizados pelos regimes totalitários do passado. Em vez disso, dissemina-se através de redes digitais descentralizadas, plataformas de alto alcance e algoritmos alimentados por padrões de comportamento humano.

É neste cenário que a inteligência artificial (IA) assume protagonismo. A velocidade, a escala e a complexidade do fluxo informacional tornaram inviáveis os métodos exclusivamente humanos de monitorização e deteção de manipulação. Plataformas como Facebook, X (antigo Twitter), TikTok e YouTube recebem milhões de novos conteúdos a cada minuto; muitos deles são inofensivos, outros são deliberadamente fabricados para enganar, polarizar, radicalizar ou confundir. A IA surge como uma ferramenta indispensável para identificar, classificar e mitigar esta expansão crescente de conteúdo manipulador.

Contudo, a tecnologia que procura combater a manipulação é, paradoxalmente, a mesma que pode ser utilizada para a intensificar. Os modelos de IA não são neutros: refletem as escolhas dos programadores, as características dos datasets, os critérios de anotação e os interesses de quem os controla. Esta ambivalência exige um olhar crítico sobre o seu desenvolvimento, funcionamento e impacto.

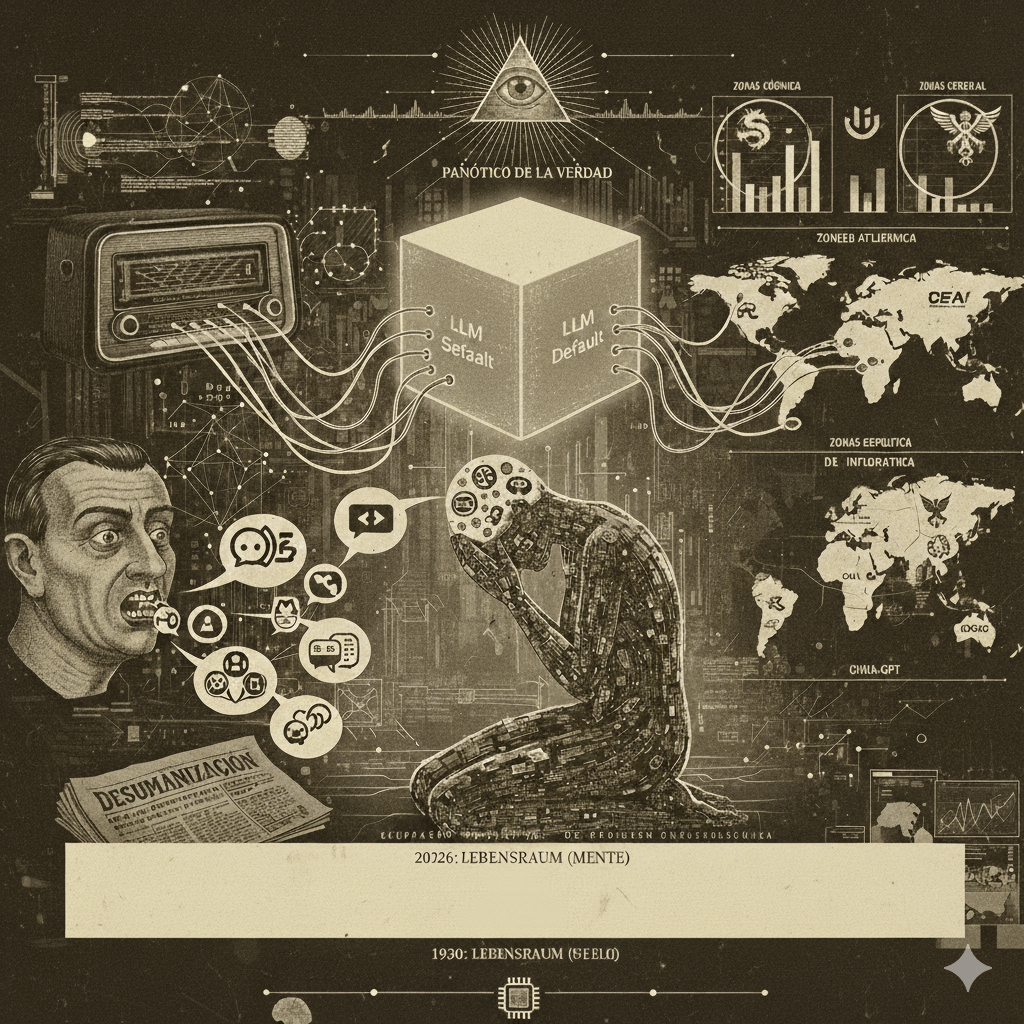

A história oferece exemplos preocupantes. A propaganda nazi mostra como narrativas cuidadosamente construídas podem moldar identidades, fabricar inimigos comuns e justificar atrocidades [2]. A grande lição é clara: a manipulação não é acidental — é projetada, estratégica e poderosa. Hoje, essa capacidade foi amplificada pela tecnologia.

Este artigo explora, em profundidade, o desenvolvimento de modelos de IA dedicados à identificação de conteúdo manipulador, avaliando: os fundamentos técnicos que sustentam estes modelos; os riscos éticos e sociais envolvidos; a forma como a história ajuda a compreender padrões de manipulação; a ligação entre tecnologia, política e poder; e as estratégias necessárias para garantir que a IA reforça – e não ameaça – a integridade democrática.

2. Fundamentação Teórica: Da Retórica Histórica à Propaganda Computacional

2.1. A Retórica da Propaganda Histórica

A propaganda, enquanto comunicação estratégica para influenciar atitudes e comportamentos, tem sido um fenómeno central na história política. A propaganda nazi, em particular, é um estudo de caso paradigmático da aplicação sistemática de princípios retóricos para fins destrutivos.

A retórica clássica, baseada nos pilares de Aristóteles (Ethos, Pathos, Logos), foi subvertida para construir uma narrativa totalitária. O Ethos (credibilidade) era construído em torno do mito do líder infalível (Adolf Hitler). O Logos (lógica) era substituído por argumentos simplistas e falaciosos. O Pathos (emoção) era o pilar central, explorando o medo, a raiva e o orgulho nacional para criar uma Volksgemeinschaft (Comunidade do Povo) unida contra um inimigo comum [2].

As características centrais da propaganda nazi incluíam:

- Desumanização: A representação sistemática de grupos minoritários (Judeus, Ciganos, etc.) como pragas, doenças ou sub-humanos, justificando a violência e a exclusão [1] [3].

- Simplificação Extrema: Redução de problemas complexos a causas únicas e identificáveis (ex: “o Judeu é o culpado”).

- Repetição Constante: A saturação dos meios de comunicação com as mesmas mensagens e símbolos.

2.2. Inteligência Artificial e Análise de Comunicação

O Processamento de Linguagem Natural (PLN) e o Machine Learning oferecem ferramentas para analisar grandes volumes de texto e discurso, permitindo a quantificação e a categorização de padrões retóricos que, historicamente, eram analisados apenas qualitativamente.

A IA insere-se no campo da Propaganda Computacional, definida como a utilização de algoritmos, automação e grandes volumes de dados para manipular a opinião pública [5] [6]. A IA não só permite a análise de textos históricos, como também é a tecnologia subjacente à nova ecologia da influência digital, que é:

- Descentralizada: A manipulação ocorre em múltiplos nós da rede.

- Amplificada por Algoritmos: Os algoritmos de recomendação priorizam conteúdo emocionalmente intenso e polarizador.

- Automatizada: O uso de bots e contas falsas simula apoio popular e coordena a disseminação de narrativas [6].

A IA, portanto, é simultaneamente o objeto de estudo (como ferramenta de manipulação) e a ferramenta de análise (como mecanismo de deteção).

3. Eixo I: Análise Retórica e Linguística com IA

A IA permite ir além da análise de conteúdo para identificar a intenção e a técnica da manipulação.

3.1. Padrões de Desumanização e Linguagem Polarizadora

Modelos de PLN podem ser treinados para identificar padrões de desumanização na propaganda histórica e contemporânea. A análise linguística pode quantificar a frequência e o contexto da mental state language (linguagem de estado mental) dirigida a grupos minoritários, revelando a estratégia de negação da humanidade do outro [1].

A IA deteta frases que promovem binarismos (“Nós contra eles”, “Inimigos do povo”), uma estrutura retórica antiga que a propaganda nazi aplicou sistematicamente para isolar grupos específicos.

3.2. Análise de Sentimento e Emoção

A propaganda é, acima de tudo, um apelo ao Pathos. Algoritmos de análise de sentimento e emoção podem mapear o uso estratégico de palavras e expressões destinadas a provocar:

- Medo (ex: ameaças existenciais, invasão).

- Raiva (ex: injustiça, traição).

- Pânico Moral (ex: decadência da sociedade, perda de valores).

Ao quantificar a intensidade emocional do discurso, a IA ajuda a identificar conteúdos com maior potencial manipulador, independentemente da sua veracidade factual.

4. Eixo II: Disseminação e Alcance da Propaganda

4.1. Modelos Históricos vs. Amplificação Algorítmica

A propaganda nazi dependia de instituições centralizadas (rádio, imprensa, cinema) para a disseminação unidirecional [2]. Hoje, a manipulação é micro-direcionada (microtargeting). Plataformas digitais utilizam dados de utilizadores para personalizar conteúdos, permitindo que campanhas de manipulação sejam altamente direcionadas, com discursos diferentes para pessoas diferentes, refinando continuamente narrativas eficazes.

A IA pode ser usada para simular e modelar o alcance e a eficácia da propaganda em diferentes redes sociais, comparando a sua propagação com a dos meios históricos. Esta análise revela que a continuidade dos padrões retóricos da propaganda histórica é amplificada pela novidade dos mecanismos algorítmicos.

4.2. Deteção de Imagens e Vídeos Manipulados

A manipulação visual exige técnicas próprias. A IA é crucial na deteção de deepfakes, criados com Redes Adversariais Generativas (GANs). A IA identifica montagens através de:

- Artefactos digitais e iluminação incoerente.

- Microexpressões impossíveis ou inconsistências temporais.

Esta capacidade é vital, dado que a propaganda nazi utilizava intensamente a imagem (pósteres, filmes) para veicular a sua retórica de desumanização (ver Tabela 1).

5. Eixo III: Deteção e Contramedidas de IA

O desenvolvimento de modelos de IA para a deteção automática de discurso de ódio (hate speech) e desinformação é uma área de investigação crucial [8] [9].

5.1. Desafios e a Importância dos Datasets

A base de qualquer modelo é o dataset. Para treinar sistemas de deteção, reúnem-se milhões de exemplos anotados por humanos. A anotação é crucial, pois classifica não só a veracidade, mas também o tom emocional, a intenção provável e a técnica de manipulação usada. Modelos mal treinados geram classificações injustas, enviesadas ou inconsistentes.

Os modelos mais avançados, como os baseados na arquitetura transformer (BERT, GPT, RoBERTa), são capazes de compreender contexto, captar ironia e nuances emocionais, tornando possível a identificação de manipulação em escala global [10].

5.2. O Papel da IA Explicável (XAI) e os Desafios Éticos

A eficácia da IA na deteção de conteúdo manipulador é inegável, mas levanta desafios éticos significativos. O risco da “IA censora” é real: se a IA detetar conteúdo de forma autónoma, quem controla as decisões? Quem define o que é manipulação?

O Papel da IA Explicável (XAI) é fundamental para mitigar este risco [7]. Modelos devem justificar as suas decisões, permitindo que investigadores e utilizadores compreendam o porquê de uma classificação. Sem explicabilidade, o poder algorítmico torna-se uma “caixa negra” perigosa, suscetível a:

- Enviesamentos Sistémicos: Penalizar minorias ou confundir crítica política com manipulação.

- Abuso por Regimes Autoritários: Utilizar a tecnologia para silenciar a oposição.

6. Conclusão

A desinformação do século XXI representa um desafio complexo, global e multifacetado. A manipulação informacional tornou-se mais sofisticada, mais distribuída e mais difícil de rastrear do que qualquer forma de propaganda histórica. A inteligência artificial surge como uma ferramenta necessária — mas não suficiente — para identificar e mitigar conteúdos manipuladores.

Os modelos de IA podem ajudar a preservar a integridade democrática, a proteger cidadãos, a filtrar conteúdos perigosos e a desmantelar campanhas coordenadas. Contudo, também transportam riscos significativos: enviesamento, censura algorítmica, opacidade decisória e potencial abuso por atores autoritários.

A resposta exige equilíbrio entre tecnologia, ética, política e cidadania. Assim como a propaganda nazi nos lembra os perigos da manipulação institucionalizada, o presente exige uma vigilância constante para garantir que os sistemas que criamos reforçam — e não minam — a verdade, a liberdade e a dignidade humana. A literacia mediática e a transparência algorítmica são a melhor defesa contra a retórica do ódio, seja ela veiculada por um póster histórico ou por um algoritmo moderno.

APÊNDICES

Apêndice A – Explicações Técnicas e Conceituais

A.1. Word Embeddings e Representações Semânticas

Os word embeddings são representações numéricas que projetam palavras num espaço multidimensional. Uma forma acessível de compreendê-los é imaginar um mapa semântico, onde palavras com significados próximos surgem mais próximas entre si. Relações linguísticas estáveis, como género ou hierarquia, emergem como direções consistentes nesse espaço vetorial.

A.2. Modelos Baseados em Transformers

Modelos como BERT, RoBERTa ou GPT utilizam mecanismos de self-attention para captar relações de contexto, dependências longas e nuances retóricas. A sua capacidade para analisar linguagem em múltiplos níveis simultaneamente torna-os adequados para tarefas como deteção de discurso de ódio, propaganda e manipulação.

A.3. Datasets Utilizados na Detecção de Toxicidade e Manipulação

A investigação depende de corpora anotados manualmente. Entre os mais relevantes:

- Jigsaw Toxic Comments Dataset – Comentários rotulados por toxicidade, ameaças e insultos.

- HateXplain – Inclui classificações e explicações humanas, facilitando XAI.

- OLID / OffensEval – Corpus multilingue para discurso ofensivo.

- HateBR – Corpus para o português do Brasil, evidenciando a lacuna existente para o português europeu.

A escassez de datasets em PT-PT limita a robustez de modelos aplicáveis ao contexto português.

A.4. Métricas de Avaliação

A eficácia dos modelos é avaliada através de:

- Precisão – proporção de classificações corretas entre as preditas como positivas.

- Recall – proporção de casos positivos corretamente identificados.

- F1-score – média harmónica entre precisão e recall.

Modelos contemporâneos obtêm F1 entre 0.75 e 0.90, dependendo da tarefa e da complexidade linguística.

A.5. IA Explicável (XAI)

Ferramentas como LIME ou SHAP permitem identificar quais tokens contribuíram para uma previsão. A explicabilidade reduz o risco de decisões injustificadas, tornando os modelos auditáveis e mais compatíveis com princípios democráticos e regulatórios.

Apêndice B – Casos Contemporâneos de Manipulação Digital

B.1. Campanhas Anti-Vacinação (2020–2021)

Durante a pandemia, redes coordenadas de desinformação disseminaram conteúdos que retratavam vacinas como perigosas, corruptas ou parte de conspirações globais. Foram identificados padrões clássicos de propaganda: apelo ao medo, simplificação extrema e criação de inimigos internos. Bots e contas automatizadas amplificaram tais narrativas em Facebook, Telegram e YouTube.

B.2. Interferência Eleitoral Global

Eleições nos EUA, Brasil, Índia e vários países europeus registaram:

- vídeos manipulados,

- declarações falsas atribuídas a candidatos,

- hashtags coordenadas para manipular tendências,

- contas automatizadas para amplificação de conteúdos.

Os mecanismos técnicos integram estratégias retóricas clássicas: bodes expiatórios, apelo emocional radical e repetição intensiva.

B.3. Guerra Rússia–Ucrânia

Desde 2022, têm circulado:

- deepfakes de líderes políticos e militares,

- vídeos de conflitos antigos apresentados como atuais,

- narrativas polarizadoras disseminadas por redes coordenadas.

Este caso demonstra a convergência entre tecnologias generativas e propaganda transnacional.

B.4. Caso Português

Portugal também apresenta fenómenos relevantes de desinformação:

Eleições Legislativas e Autárquicas (2021–2024)

Fact-checkers portugueses documentaram:

- circulação de vídeos que alegavam destruição de boletins de voto (desmentidos pelo Polígrafo),

- imagens de urnas supostamente manipuladas, retiradas de contextos anteriores ou de outros países,

- declarações xenófobas atribuídas falsamente a candidatos, verificadas como falsas (Observador Fact Check).

Narrativas Anti-Imigração

Páginas anónimas e redes de conteúdos polarizadores difundiram:

- imagens antigas de confrontos apresentadas como recentes,

- alegações infundadas sobre criminalidade associada a grupos específicos,

- desinformação amplificada em TikTok com elevada carga emocional.

Investigação do OberCom e relatórios do EUvsDisinfo confirmam circulação de narrativas importadas e adaptadas ao contexto nacional.

Apêndice C – IA Generativa: Arma e Escudo da Informação

C.1. Produção Automatizada de Desinformação

Modelos generativos permitem criar artigos falsos, testemunhos fictícios ou narrativas políticas altamente persuasivas, adaptadas a perfis de utilizador (microtargeting). Esta capacidade aumenta a escala e a personalização da desinformação.

C.2. Imagens Sintéticas e Deepfakes de Voz

Ferramentas como Midjourney, Stable Diffusion e modelos avançados de clonagem de voz possibilitam:

- retratos hiper-realistas de eventos inexistentes,

- discursos falsos com voz indistinguível da original,

- vídeos manipulados com alta fidelidade visual.

C.3. Sistemas de Detecção de Conteúdo Sintético

Desenvolvem-se modelos especializados em identificar artefactos visuais, inconsistências linguísticas ou padrões estatísticos típicos de conteúdos sintéticos. Estas ferramentas tornam-se essenciais para investigação forense digital.

C.4. O Modelo de Negócio das Big Tech como Problema Estrutural

A circulação de desinformação está ligada ao modelo económico das plataformas digitais:

- Algoritmos privilegiam conteúdos emocionalmente intensos porque aumentam engagement e receitas publicitárias.

- Moderação rigorosa pode colidir com objetivos de crescimento.

- A autorregulação tem sido insuficiente — casos como Cambridge Analytica, o genocídio dos Rohingya em Myanmar, ou o ataque ao Capitólio em 6 de janeiro expõem falhas graves.

A IA generativa é, assim, simultaneamente problema e ferramenta de mitigação.

Apêndice D – Roteiro de Ação Multinível

D.1. Governos

- Implementar auditorias independentes aos sistemas de moderação algorítmica.

- Estabelecer normas internacionais de transparência e interoperabilidade.

- Prever sanções graduais para plataformas que ocultem dados ou recusem auditorias.

- Financiar investigação e criação de corpora robustos em português europeu.

D.2. Plataformas Digitais

- Garantir acesso a APIs e dados para investigação e auditoria.

- Publicar relatórios periódicos de métricas, enviesamentos e taxas de erro.

- Integrar ferramentas de explicação para decisões algorítmicas.

- Criar mecanismos de recurso rápido e transparente para utilizadores injustamente penalizados.

D.3. Academia

- Desenvolver datasets para PT-PT e estudos comparativos internacionais.

- Investir em metodologias de IA explicável para moderação de conteúdo.

- Estudar continuidades entre propaganda histórica e contemporânea.

D.4. Cidadãos

- Reforçar literacia mediática desde o ensino básico.

- Estimular práticas de verificação antes da partilha.

- Promover consciência crítica sobre conteúdos emocionalmente intensos.

Glossário

Corpus – Conjunto de textos estruturados utilizados para treino ou avaliação de modelos de IA.

Anotação – Processo de rotulagem manual de dados (ex.: discurso de ódio, ironia, propaganda).

Transformer – Arquitetura de IA capaz de analisar sequências linguísticas com mecanismos de atenção.

Embedding – Representação numérica do significado de uma palavra.

F1-score – Métrica que combina precisão e recall para avaliar desempenho.

XAI (Explainable AI) – Técnicas que tornam modelos mais transparentes e interpretáveis.

Deepfake – Conteúdo audiovisual gerado artificialmente com forte aparência de autenticidade.

Microtargeting – Direcionamento de mensagens políticas ou comerciais baseado em dados individuais granulares.

Bot – Conta automatizada que simula atividade humana para amplificar conteúdos ou manipular conversações.

Sugestões de Multimédia (Vídeos e Imagens)

Para ilustrar os pontos de análise retórica e a aplicação da IA, sugerem-se os seguintes tipos de multimédia:

Imagens (Análise Retórica da Propaganda Nazi)

| Tipo de Imagem | Propósito Explicativo | Secção do Artigo |

|---|---|---|

| Póster de Desumanização | Ilustrar o uso de metáforas visuais para a criação do “inimigo” (ex: Judeu como monstro, aranha, ou bolchevique como gorila). | Secção 2.1 e 3.1 https://encyclopedia.ushmm.org/images/large/6d382286-b019-4bc7-b76b-3cddc5d66c5e.jpeg |

| Póster de Apelo à Unidade/Família | Ilustrar o apelo ao Ethos e à Volksgemeinschaft (Comunidade do Povo) para angariar apoio interno. | Secção 2.1 https://exhibitions.ushmm.org/storage/1035/810b521e-d2ec-11ec-83c9-0a86e68a834f.jpeg |

| Póster de Corrupção/Inimigo Interno | Ilustrar a retórica de simplificação e a identificação de bodes expiatórios para problemas sociais. | Secção 2.1 https://pt.wikipedia.org/wiki/Ficheiro:%22I%27ll_Give%27em_Hell_-_You_Give_Me_the_Stuff%22_-_NARA_-_514599.jpg |

Vídeos (Análise Histórica e Aplicação de IA)

| Tipo de Vídeo | Propósito Explicativo | Sugestão de Conteúdo | Secção do Artigo |

|---|---|---|---|

| Excerto de Discurso de Hitler | Demonstrar a oratória e o uso do Pathos (emoção) na comunicação de massas. | Excerto de discursos em comícios (ex: Nuremberg) com foco na linguagem corporal e entonação. | Secção 3.2 |

| Documentário/Explicação da Propaganda | Contextualizar a propaganda nazi e o seu impacto social. | Vídeos educativos de instituições como o Museu do Holocausto (USHMM) ou canais académicos. | Secção 1 e 2.1 https://encyclopedia.ushmm.org/content/pt-br/gallery/nazi-propaganda-films |

| Demonstração de Modelo de IA | Ilustrar visualmente a aplicação da IA na análise de texto. | Vídeos ou gráficos que demonstrem a visualização de dados de análise de sentimento ou deteção de discurso de ódio. | Secção 3.1 e 5.1 |

Gráficos (Aplicação de IA)

| Tipo de Gráfico | Propósito Explicativo | Secção do Artigo |

|---|---|---|

| Diagrama de Deteção de Conteúdo | Representar o fluxo de trabalho de um sistema de IA para detetar conteúdo prejudicial. | Secção 5.1 |

| Gráfico de Análise de Discurso de Ódio | Ilustrar a quantificação de padrões de discurso de ódio ou a distribuição de utilizadores que o produzem. | Secção 5.1 |

| Gráfico de Word Embeddings | Visualizar como os modelos de IA (PLN) mapeiam conceitos e relações semânticas (ex: a relação entre “Rei” e “Rainha” vs. “Homem” e “Mulher” para ilustrar vieses). | Secção 3.1 |

Diagrama de Deteção de Conteúdo

(Fluxo de Trabalho — Secção 5.1)

Imagina um pequeno rio tecnológico, onde cada etapa filtra um pouco mais da água. Em texto, fica assim:

┌──────────────────────────┐

│ Novo Post │

│ (entrada do sistema) │

└─────────────┬────────────┘

↓

┌──────────────────────────┐

│ Pré-processamento │

│ (limpeza, remoção de ruído) │

└─────────────┬────────────┘

↓

┌──────────────────────────┐

│ Modelo de IA │

│ (classificação) │

└─────────────┬────────────┘

↓

┌──────────────────────────┐

│ Decisão │

│ Aprovado | Rejeitado | │

│ Enviado para revisão │

│ humana │

└──────────────────────────┘

Serve para mostrar como um sistema detecta conteúdo tóxico: entrada, limpeza, classificação, e depois uma escolha final.

“Nuvem de Palavras” para Análise de Discurso de Ódio

(Secção 5.1 — versão textual)

Como não estamos a usar imagens verdadeiras, posso representar uma nuvem de palavras com variação de tamanho usando maiúsculas e repetição. As palavras maiores seriam as mais frequentes num dataset português.

INSULTO ALVO

imbecil imbecil imbecil

ódio ódio

xenófobo

ofensa ofensa ofensa

atacar

minorias

A ideia é visual: quanto maior a palavra, maior a frequência. É uma forma rudimentar, mas mantém a lógica de uma nuvem real.

Representação de Word Embeddings em 2D

(Secção 3.1 — relação semântica)

Uma técnica de redução dimensional como t-SNE projecta palavras em 2D, permitindo ver como o modelo agrupa ideias. Aqui vai uma representação textual, como se fosse um pequeno mapa conceptual:

(rei) ●───────────────→ ● (rainha)

vetor “realeza + género”

(homem) ●────────────→ ● (mulher)

vetor “género humano”

O detalhe interessante está na semelhança das setas:

o “comprimento” e a “direcção” do vetor homem→mulher é quase igual ao vetor rei→rainha. É uma pista visual de que o modelo captou o conceito de género como uma transformação consistente entre pares de palavras.

Se quisermos imaginar isto como pontos aproximados num espaço 2D:

mulher ● rainha ●

\ /

\ (semelhança)

/ \

homem ● ● rei

Cada ponto é uma palavra comprimida num pequeno universo semântico. A proximidade sugere semelhança; a direção das “setas” sugere relações abstratas aprendidas.

Referências (APA v7)

- Landry, A. P. (2022). Dehumanization and mass violence: A study of mental state language in Nazi propaganda. PLoS ONE, 17(9), e0274957. https://doi.org/10.1371/journal.pone.0274957

- Welch, D. (2004). Nazi Propaganda and the Volksgemeinschaft. Journal of Contemporary History, 39(2), 213–238. https://doi.org/10.1177/0022009404042129

- Steizinger, J. (2018). The Significance of Dehumanization: Nazi Ideology and Its Rhetoric. The Journal of Holocaust Research, 32(1), 1–17. https://doi.org/10.1080/21567689.2018.1425144

- Thompson, G. (2017). Parallels in propaganda? A comparative historical analysis of Islamic State and the Nazi Party. Journal of Public Relations Research, 29(1), 1–16. https://doi.org/10.1080/1062726X.2017.1281136

- Howard, P., Lin, F., & Tuzov, V. (2023). Computational propaganda: Concepts, methods, and challenges. Communication and the Public, 8(3), 209–226. https://doi.org/10.1177/20570473231185996

- Bolsover, G., & Howard, P. N. (2017). Computational propaganda and political big data: Moving toward a more critical research agenda. Big Data, 5(4), 271–276. https://doi.org/10.1089/big.2017.29024.cpr

- Mehta, H., & Passi, K. (2022). Social media hate speech detection using explainable artificial intelligence (XAI). Algorithms, 15(8), 291. https://doi.org/10.3390/a15080291

- Tontodimamma, A., Nissi, E., Sarra, A., & Fontanella, L. (2021). Thirty years of research into hate speech: topics of interest and their evolution. Scientometrics, 126(1), 351–373. https://doi.org/10.1007/s11192-020-03737-6

- Jahan, M. S., & Oussalah, M. (2023). A systematic review of hate speech automatic detection using natural language processing. Neurocomputing, 546, 126232. https://doi.org/10.1016/j.neucom.2023.126232

- Strubytskyi, R., & Shakhovska, N. (2023). Method and models for sentiment analysis and hidden propaganda finding. Computers in Human Behavior Reports, 8, 100253. https://doi.org/10.1016/j.chbr.2023.100328

Meta descrição: Análise crítica da propaganda histórica e digital, explorando como a Inteligência Artificial deteta desinformação, discurso de ódio e manipulação online.

Palavras-chave:

- Propaganda

- Desinformação

- Inteligência Artificial

- Análise de Discurso

- Discurso de Ódio

- PLN (Processamento de Linguagem Natural)

- Moderação Algorítmica

- IA Generativa

- Deepfakes

- Retórica

Long-tail keywords:

Focadas no tema central:

- como a IA deteta propaganda e manipulação digital

- história da propaganda nazi e paralelos com redes sociais atuais

- uso de inteligência artificial na identificação de discurso de ódio

- impacto da moderação algorítmica na liberdade de expressão

- modelos de PLN aplicados à análise retórica e desinformação

- riscos e desafios éticos da detecção automática de manipulação

Focadas em aplicabilidade:

- como identificar campanhas de desinformação em Portugal

- ferramentas de IA para detectar imagens falsas e deepfakes

- exemplos reais de manipulação online durante eleições

- diferenças entre sátira, ironia e discurso de ódio em sistemas de IA

- como funcionam datasets de discurso ofensivo e hate speech

Variantes / sinónimos:

Propaganda / Manipulação

- manipulação informacional

- propaganda digital

- persuasão maliciosa

- influência algorítmica

- engenharia social digital

- campanhas coordenadas

- informação manipulada

Desinformação

- fake news

- notícias falsas

- boatos digitais

- conteúdos manipulados

- enganos online

- narrativas falsificadas

- informação enganosa

Inteligência Artificial

- sistemas algorítmicos

- aprendizagem automática

- machine learning

- modelos linguísticos

- IA generativa

- modelos de linguagem

- algoritmos de moderação

Discurso de ódio

- linguagem tóxica

- ataques verbais

- discurso ofensivo

- retórica hostil

- incitamento ao ódio

- linguagem agressiva

Moderação/Deteção

- deteção automática

- moderação digital

- triagem algorítmica

- classificação automática

- análise computacional

- verificação digital

- sistemas de controlo de conteúdo

Este artigo faz parte de uma série sobre a propaganda nazi e as suas implicações contemporâneas, desenvolvida como parte do meu projeto final de pós-graduação em Comunicação e Inteligência Artificial na Universidade Católica Portuguesa.

Como citar este artigo: Santos, N. (2026). The Rhetoric of Hate in Algorithms: A Critical Analysis of Nazi Propaganda Through the Lens of Artificial Intelligence. Zenodo. https://doi.org/10.5281/zenodo.18482102

Deixe um comentário