1. Introdução: Persuasão na Era Algorítmica

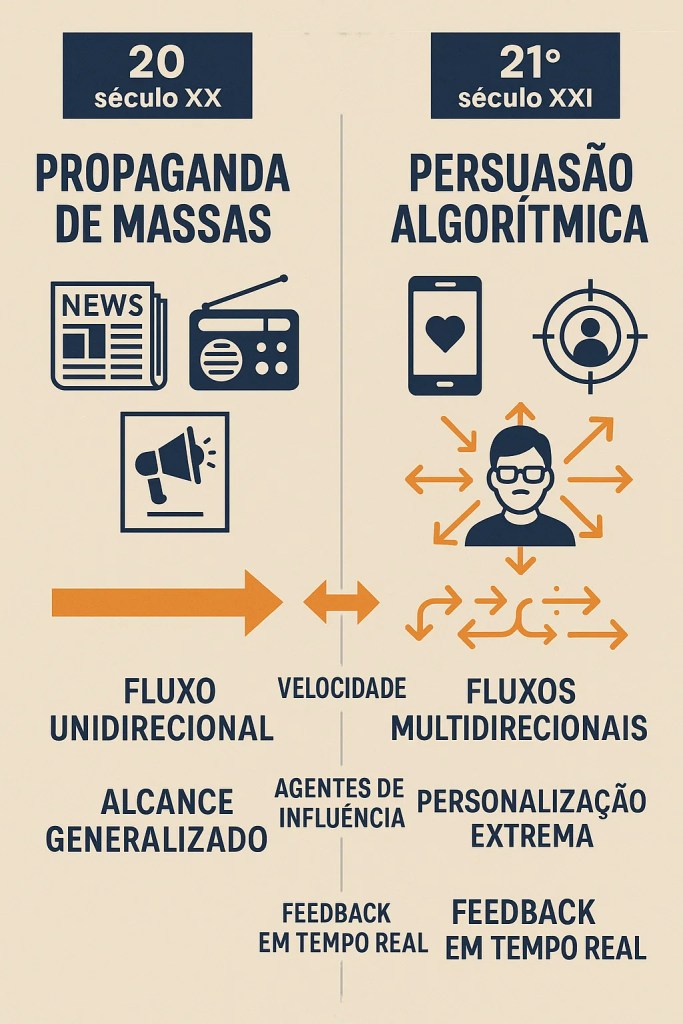

A comunicação política atravessa uma metamorfose profunda, impulsionada pela ascensão da Inteligência Artificial (IA) e pela omnipresença das redes sociais. Se no passado a persuasão desenrolava-se em palcos físicos e através de meios de comunicação de massas com intermediários bem definidos, hoje assistimos a uma reconfiguração radical deste paradigma. A capacidade de influenciar o pensamento e o comportamento coletivo tornou-se mais granular, mais personalizada e, em muitos aspetos, mais insidiosa. As plataformas digitais, alimentadas por algoritmos sofisticados, não são meros canais de transmissão de mensagens; são arquiteturas de influência ativamente moldadas para capturar a atenção e modular a percepção.

É crucial reconhecer que, embora as ferramentas sejam novas, a essência de muitas técnicas de persuasão e manipulação encontra ecos em estratégias propagandísticas clássicas. A repetição exaustiva de slogans, a simplificação de questões complexas em narrativas binárias, a construção de “inimigos” comuns e o apelo a emoções primárias – táticas amplamente exploradas por regimes como o nazi – encontram novas roupagens e uma eficácia amplificada no ecossistema digital. A diferença reside na escala, na velocidade, na precisão do direcionamento e na aparente invisibilidade dos mecanismos em jogo.

A compreensão aprofundada destas dinâmicas é mais do que um exercício académico; é uma necessidade premente para a salvaguarda da saúde democrática e da integridade do discurso público. Num tempo em que a fronteira entre informação e desinformação se torna cada vez mais ténue, e em que a capacidade de discernimento individual é constantemente desafiada por um fluxo incessante de conteúdo personalizado, a literacia mediática e a consciência crítica emergem como pilares fundamentais da cidadania.

2. Técnicas Contemporâneas de Persuasão Digital Baseadas em IA

A revolução digital não transformou apenas os canais de comunicação, mas também sofisticou exponencialmente as técnicas de persuasão. As ferramentas baseadas em inteligência artificial representam um salto qualitativo na capacidade de influenciar comportamentos e moldar percepções, operando frequentemente abaixo do limiar da consciência crítica dos utilizadores. Exploremos as principais técnicas que definem esta nova fronteira da persuasão digital.

2.1 Microtargeting Comportamental Baseado em Big Data

O microtargeting representa uma rutura fundamental com as estratégias de persuasão de massas do passado. Esta técnica assenta na recolha e análise massiva de dados comportamentais, demográficos e psicográficos para segmentar audiências em grupos cada vez mais específicos – por vezes chegando ao nível individual. O microtargeting político transforma a comunicação de uma atividade pública para uma experiência privada e personalizada, dificultando o escrutínio coletivo das mensagens políticas.

A Cambridge Analytica tornou-se o caso paradigmático desta abordagem, utilizando dados de mais de 87 milhões de utilizadores do Facebook para criar perfis psicológicos detalhados que permitiram direcionar mensagens políticas altamente personalizadas durante a campanha presidencial americana de 2016 e o referendo do Brexit. A empresa alegou ter identificado cinco traços de personalidade (o modelo OCEAN: Abertura, Conscienciosidade, Extroversão, Amabilidade e Neuroticismo) para adaptar mensagens políticas que ressoassem com vulnerabilidades psicológicas específicas (Cadwalladr & Graham-Harrison, 2018).

2.2 A/B Testing Emocional em Campanhas Políticas Digitais

As plataformas digitais permitem testar múltiplas variações de mensagens em tempo real, otimizando continuamente o impacto emocional e a eficácia persuasiva. Esta técnica, conhecida como A/B testing, é agora aplicada sistematicamente em campanhas políticas para identificar quais as imagens, frases, cores ou enquadramentos que geram maior envolvimento emocional em diferentes segmentos do eleitorado.

Um exemplo recente e significativo ocorreu nas eleições europeias de 2024, onde uma investigação da AlgorithmWatch (2024) documentou como um partido populista testou simultaneamente mais de 200 variações de mensagens anti-imigração em diferentes segmentos demográficos, ajustando em tempo real o tom, as imagens e até mesmo os dados apresentados conforme a resposta emocional dos utilizadores. Esta capacidade de experimentação massiva e ajuste contínuo representa uma vantagem estratégica significativa face às campanhas tradicionais.

2.3 Bots e Chatbots na Criação de “Consenso Fabricado”

A proliferação de contas automatizadas (bots) nas redes sociais introduziu uma nova dimensão na manipulação da perceção pública. Estas entidades artificiais podem simular apoio massivo a determinadas ideias, criar a ilusão de consenso ou deslegitimar opositores através de ataques coordenados. Um estudo da Universidade de Oxford identificou operações de bots em mais de 70 países entre 2022 e 2024, com níveis crescentes de sofisticação na simulação de comportamento humano (Bradshaw & Howard, 2024).

Os chatbots baseados em modelos de linguagem avançados representam a evolução mais recente desta tendência. Capazes de manter conversas aparentemente naturais e adaptar argumentos persuasivos em tempo real, estas ferramentas estão a ser cada vez mais utilizadas para interações políticas personalizadas. Acapacidade destes sistemas para adaptar argumentos com base nas respostas do interlocutor cria uma experiência de persuasão interativa que maximiza a eficácia retórica.

2.4 Personalização Algorítmica de Conteúdo para Reforço de Crenças

Os algoritmos que governam as plataformas digitais não são neutros na seleção e apresentação de conteúdos. Pelo contrário, são otimizados para maximizar o engajamento, frequentemente através do reforço de crenças pré-existentes e da exposição preferencial a conteúdos que confirmam os vieses do utilizador. Este fenómeno, conhecido como “filter bubble” ou câmara de eco, tem implicações profundas para o debate democrático.

O algoritmo de recomendação do YouTube demonstrou como utilizadores são progressivamente direcionados para conteúdos cada vez mais extremos dentro do seu espectro de interesse, criando um “funil de radicalização” algorítmico. Este mecanismo não apenas reforça convicções existentes, mas também as intensifica, contribuindo para a polarização do discurso público.

2.5 Storytelling Automatizado com Base em Análise de Sentimento

A capacidade de analisar o sentimento dominante em comunidades online e adaptar narrativas em tempo real representa outra inovação significativa. Algoritmos de IA monitorizam continuamente o tom emocional de conversas em plataformas digitais, identificando temas ressonantes, medos coletivos e aspirações que podem ser explorados em narrativas políticas personalizadas.

Esta técnica foi documentada nas eleições presidenciais brasileiras de 2022, onde campanhas utilizaram análise de sentimento em tempo real para ajustar narrativas políticas conforme as flutuações emocionais do eleitorado em diferentes regiões do país. A capacidade de identificar e explorar vulnerabilidades emocionais coletivas em tempo real representa uma evolução significativa face às técnicas tradicionais de persuasão.

2.6 Deepfakes para Desinformação Visual e Manipulação da Realidade

Talvez nenhuma tecnologia encarne melhor os desafios da era da persuasão algorítmica do que os deepfakes – conteúdos audiovisuais sintéticos gerados por IA que podem simular de forma convincente pessoas reais a dizer ou fazer coisas que nunca ocorreram. Esta tecnologia, baseada em Redes Adversariais Generativas (GANs), representa uma ameaça fundamental à confiança no testemunho audiovisual, tradicionalmente considerado uma evidência fiável.

Um caso particularmente significativo ocorreu em março de 2024, quando um deepfake do presidente ucraniano Volodymyr Zelensky a anunciar uma rendição foi brevemente transmitido após um ataque hacker a uma emissora de televisão. Embora rapidamente desmentido, o incidente demonstrou o potencial desestabilizador desta tecnologia em contextos geopolíticos sensíveis (European Digital Media Observatory, 2024).

3. Estratégias de Desinformação Digital Facilitadas por IA

Se as técnicas de persuasão digital representam uma evolução nas formas de influenciar atitudes e comportamentos, as estratégias de desinformação facilitadas por IA constituem um salto qualitativo na capacidade de distorcer a própria realidade informativa. Estas estratégias não visam apenas persuadir, mas sim contaminar o ecossistema informativo com conteúdos falsos ou enganosos, minando a capacidade coletiva de discernimento.

3.1 Geração Automática de Fake News com Modelos de Linguagem

Os modelos de linguagem de grande escala (LLMs) revolucionaram a capacidade de produzir texto sintético indistinguível do conteúdo humano. Ferramentas como o GPT-4 e similares podem gerar artigos noticiosos falsos com uma sofisticação linguística e coerência narrativa que desafiam a deteção, mesmo por leitores atentos. Esta capacidade de produção massiva de conteúdo falso de alta qualidade representa uma ameaça sem precedentes ao ecossistema informativo.

3.2 Amplificação via Algoritmos de Recomendação

A desinformação, mesmo quando sofisticada, seria menos impactante sem os mecanismos algorítmicos que amplificam o seu alcance. Os algoritmos de recomendação das principais plataformas digitais – YouTube, Facebook, TikTok – são otimizados para maximizar o engajamento, frequentemente favorecendo conteúdos emocionalmente ativadores, controversos ou alarmistas, características comuns em materiais desinformativos.

Conteúdos com alegações falsas sobre saúde pública receberam, em média, 4,7 vezes mais envolvimento no Facebook do que desmentidos factuais sobre os mesmos temas, criando um incentivo perverso para a produção e disseminação de desinformação. Esta dinâmica de “economia da atenção” transforma os algoritmos em amplificadores involuntários de conteúdo problemático.

3.3 Criação de Câmaras de Eco e Reforço de Polarização Cognitiva

A segmentação algorítmica de utilizadores em grupos de afinidade informativa cria ambientes digitais onde a exposição a perspetivas diversas é minimizada, enquanto visões consonantes com as crenças pré-existentes são constantemente reforçadas. Estas “câmaras de eco” não apenas isolam os utilizadores de informações contraditórias, mas também intensificam gradualmente as suas convicções através da exposição repetida a conteúdos cada vez mais extremos.

3.4 Ataques Coordenados via Contas Falsas para Manipular Trending Topics

A manipulação da visibilidade algorítmica através de ações coordenadas representa outra estratégia sofisticada de desinformação digital. Redes de contas falsas, frequentemente automatizadas, podem criar a ilusão de interesse orgânico em determinados tópicos, manipulando os sistemas de “trending topics” das plataformas sociais e influenciando a agenda mediática.

Um exemplo particularmente relevante ocorreu durante as eleições europeias de 2024, onde se identificou uma rede de mais de 7.000 contas falsas que atuaram de forma coordenada para promover narrativas anti-imigração em cinco países europeus. A operação utilizou técnicas sofisticadas de “astroturfing” – simulação de movimentos populares espontâneos – para criar a percepção de uma onda de indignação pública que foi subsequentemente amplificada por meios de comunicação tradicionais.

3.5 Engenharia Social Digital com Base em Dados Psicográficos

A combinação de big data e psicologia comportamental permite o desenvolvimento de estratégias de engenharia social altamente sofisticadas, direcionadas a vulnerabilidades psicológicas específicas. Estas abordagens exploram traços de personalidade, medos e vieses cognitivos para maximizar a recetividade a narrativas desinformativas.

A engenharia social contemporânea não visa apenas enganar indivíduos, mas explorar sistematicamente vulnerabilidades psicológicas identificadas através da análise de dados comportamentais para maximizar a adesão a narrativas falsas. Esta personalização da desinformação representa um desafio significativo para as estratégias tradicionais de verificação de factos, que tipicamente não consideram as dimensões psicológicas da receptividade à desinformação.

4. Impacto Psicossocial das Novas Técnicas de Persuasão

As técnicas de persuasão e desinformação potenciadas por IA não operam num vácuo; têm consequências profundas para a cognição individual e coletiva, para a coesão social e para o funcionamento das instituições democráticas. Compreender estes impactos é essencial para desenvolver respostas eficazes aos desafios da era da persuasão algorítmica.

4.1 Redução da Autonomia Crítica e Aumento da Vulnerabilidade à Manipulação

A exposição contínua a conteúdos personalizados que reforçam crenças pré-existentes pode gradualmente erodir a capacidade de pensamento crítico e avaliação independente. A personalização algorítmica cria uma experiência informativa que raramente desafia as nossas convicções, privando-nos das oportunidades de exercitar o músculo do pensamento crítico.

Esta erosão da autonomia crítica é particularmente preocupante quando combinada com técnicas de persuasão cada vez mais sofisticadas. A investigação de Martins e Alves (2024) demonstrou que indivíduos expostos predominantemente a conteúdos alinhados com as suas crenças durante um período de seis meses apresentaram uma redução significativa na capacidade de identificar falácias lógicas e avaliar criticamente argumentos contrários às suas posições.

4.2 Polarização Afetiva e Perceção Distorcida da Realidade Social

A segmentação algorítmica não apenas isola os utilizadores em bolhas informativas, mas também intensifica a polarização afetiva – o desenvolvimento de sentimentos negativos em relação a grupos políticos opostos. Esta polarização transcende discordâncias políticas específicas, transformando-se numa hostilidade generalizada baseada em identidades grupais.

Um estudo longitudinal documentou como a exposição a conteúdos políticos altamente personalizados durante um período eleitoral não apenas reforçou convicções políticas, mas também aumentou significativamente a antipatia e a atribuição de motivações maliciosas a apoiantes de partidos opostos. Esta “tribalização” do discurso político mina a possibilidade de deliberação democrática construtiva.

Paralelamente, a exposição seletiva a informações cria perceções radicalmente diferentes da realidade social. Cidadãos que habitam ecossistemas informativos distintos não apenas discordam sobre interpretações; frequentemente operam com conjuntos de ‘factos’ mutuamente exclusivos, tornando o diálogo praticamente impossível.

4.3 Normalização da Mentira e Erosão da Confiança nas Instituições

A exposição contínua a desinformação e a dificuldade crescente em distinguir conteúdos autênticos de falsificações sofisticadas contribuem para uma “normalização da mentira” no discurso público. Este fenómeno manifesta-se numa crescente tolerância social a imprecisões factuais e numa erosão gradual dos padrões de veracidade exigidos de figuras públicas.

Simultaneamente, a proliferação de narrativas conspirativas facilitadas por técnicas de desinformação digital mina a confiança nas instituições democráticas, científicas e mediáticas. A investigação de Carvalho e Martins (2024) identificou uma correlação significativa entre a exposição a desinformação online e a redução da confiança em instituições fundamentais como tribunais, universidades e órgãos de comunicação social.

4.4 Dissonância Cognitiva Induzida por Excesso de Informação Manipulada

O bombardeamento constante de informações contraditórias, muitas delas manipuladas, cria um estado de sobrecarga cognitiva que pode resultar em desengajamento cívico. Confrontados com narrativas mutuamente exclusivas e incapazes de determinar com confiança a veracidade das informações, muitos cidadãos optam por um ceticismo generalizado ou por um relativismo epistemológico que equipara todas as fontes de informação, independentemente da sua credibilidade.

O objetivo estratégico de muitas campanhas de desinformação contemporâneas não é necessariamente convencer o público de uma narrativa específica, mas sim semear confusão suficiente para paralisar a capacidade de discernimento e ação coletiva.

5. Breves Paralelismos Históricos (Referência Cruzada)

Embora as tecnologias digitais e a IA tenham transformado radicalmente as técnicas de persuasão e manipulação, muitos dos princípios psicológicos explorados atualmente encontram paralelos significativos em regimes propagandísticos históricos, particularmente na máquina de propaganda nazi. Estas continuidades oferecem perspetivas valiosas sobre vulnerabilidades humanas persistentes face à manipulação informativa.

5.1 Simplificação Extrema (“Slogans”)

Joseph Goebbels, Ministro da Propaganda nazi, defendia que “a propaganda deve limitar-se a um número pequeno de ideias e repeti-las incansavelmente”. Esta simplificação extrema de questões complexas em slogans facilmente memorizáveis encontra paralelo direto nas técnicas contemporâneas de otimização para algoritmos de redes sociais, que favorecem conteúdos curtos, impactantes e emocionalmente ativadores.

5.2 Enquadramento de Inimigos Comuns

A construção de um “outro” demonizado – judeus, comunistas, elites intelectuais – foi central na propaganda nazi, criando um inimigo comum que servia simultaneamente como explicação para problemas sociais complexos e como foco para canalizar ansiedades coletivas. Esta técnica de “bode expiatório” persiste nas estratégias de desinformação digital contemporâneas, embora com novos alvos e maior sofisticação retórica.

Estudos sobre campanhas de desinformação em cinco países europeus identificaram padrões consistentes de construção de “inimigos” – imigrantes, elites globais, ou instituições supranacionais – apresentados como ameaças existenciais à identidade nacional ou ao modo de vida tradicional. Como na propaganda nazi, estas narrativas oferecem explicações simplistas para problemas socioeconómicos complexos, direcionando a ansiedade coletiva para alvos específicos.

5.3 Manipulação Emocional através de Símbolos e Medo

A propaganda nazi explorou magistralmente o poder dos símbolos visuais e da manipulação emocional, particularmente o medo. Os comícios cuidadosamente coreografados, a estética visual distintiva e a exploração sistemática de ansiedades coletivas foram instrumentos centrais na consolidação do regime. As técnicas contemporâneas de persuasão digital, embora operando num contexto tecnológico radicalmente diferente, exploram mecanismos psicológicos semelhantes.

Um paralelo particularmente relevante pode ser observado na utilização de deepfakes para manipulação emocional. Se os nazis utilizavam fotomontagens e cinema para criar narrativas visuais manipuladas, as tecnologias contemporâneas de IA permitem a criação de conteúdos audiovisuais falsos com um realismo sem precedentes. Em ambos os casos, o objetivo é contornar o raciocínio crítico e apelar diretamente a respostas emocionais primárias.

A principal diferença entre a propaganda visual nazi e os deepfakes contemporâneos não reside nos princípios psicológicos explorados, mas na escala, velocidade e personalização possibilitadas pelas tecnologias digitais. Esta continuidade nos mecanismos psicológicos subjacentes, apesar da evolução tecnológica, sublinha a importância de compreender as lições históricas para enfrentar os desafios contemporâneos.

6. Conclusão: Vigilância Democrática e Resiliência Cívica

A análise das técnicas contemporâneas de persuasão e desinformação digital, potenciadas pela inteligência artificial, revela desafios profundos para as sociedades democráticas. A sofisticação crescente destas técnicas, a sua escala sem precedentes e a sua capacidade de explorar vulnerabilidades psicológicas individuais e coletivas exigem respostas igualmente sofisticadas e multidimensionais.

A primeira linha de defesa reside na promoção de uma literacia mediática robusta e adaptada ao contexto digital. Esta literacia deve transcender a mera verificação factual, incorporando a compreensão dos mecanismos algorítmicos que moldam a experiência informativa, o reconhecimento de técnicas de manipulação psicológica e o desenvolvimento de hábitos de consumo mediático diversificado e crítico. A literacia mediática para a era algorítmica deve ser entendida não apenas como uma competência individual, mas como uma prática social e uma responsabilidade cívica.

Paralelamente, a transparência algorítmica emerge como um imperativo democrático. Os mecanismos que determinam quais informações ganham visibilidade e quais permanecem obscuras não podem operar como “caixas negras” impenetráveis ao escrutínio público. Mesmo níveis modestos de transparência sobre o funcionamento de algoritmos de recomendação podem aumentar significativamente a capacidade dos utilizadores para exercer agência crítica face a conteúdos potencialmente manipulativos.

A regulação ética da IA, particularmente em contextos de comunicação política e disseminação de informação, representa outro pilar fundamental. Esta regulação deve equilibrar a proteção contra abusos com a preservação da inovação e da liberdade de expressão – um equilíbrio delicado que exige abordagens nuançadas e adaptativas. Iniciativas como o AI Act europeu representam passos importantes nesta direção, embora a velocidade da evolução tecnológica continue a desafiar a capacidade regulatória tradicional.

Por fim, a resiliência democrática face aos desafios da persuasão algorítmica exige o fortalecimento de instituições mediadoras capazes de promover um discurso público baseado em factos verificáveis e argumentação racional. Isto inclui o apoio a jornalismo de qualidade, a promoção de plataformas digitais que privilegiem a deliberação construtiva sobre a polarização, e o desenvolvimento de ferramentas tecnológicas que ampliem, em vez de diminuir, a autonomia crítica dos cidadãos.

O futuro da verdade na era da inteligência artificial não está predeterminado. A tecnologia, por si só, não determina o destino das nossas esferas informativas; são as escolhas coletivas sobre como desenvolver, regular e utilizar estas ferramentas que definirão se a IA servirá para amplificar ou minar a deliberação democrática. Esta perspectiva sublinha a importância da agência humana e da responsabilidade cívica face aos desafios da persuasão algorítmica.

Que reflexões podemos levar deste artigo para a nossa própria prática digital quotidiana? Como podemos exercer uma cidadania digital mais consciente e crítica? E que responsabilidade temos, enquanto participantes no ecossistema informativo digital, na preservação de um espaço público conducente à deliberação democrática? Estas questões, mais do que respostas definitivas, convidam a uma reflexão contínua sobre o nosso papel na era da persuasão algorítmica.

7. FAQ – Perguntas Frequentes

Como posso identificar conteúdos gerados por IA com intenção de desinformar?

Embora cada vez mais desafiador, existem alguns indicadores que podem ajudar: inconsistências factuais subtis, ausência de fontes verificáveis, perfeição linguística excessiva, e detalhes genéricos em vez de específicos. Ferramentas de deteção de conteúdo gerado por IA também estão disponíveis, embora a sua eficácia varie. A verificação cruzada com fontes credíveis continua a ser a estratégia mais fiável.

As plataformas digitais têm responsabilidade legal pela desinformação que circula nos seus serviços?

A responsabilidade legal varia significativamente entre jurisdições. Na União Europeia, o Digital Services Act estabelece novas obrigações para plataformas de grande dimensão, incluindo avaliações de risco relacionadas com desinformação e maior transparência sobre sistemas de recomendação. Contudo, o equilíbrio entre responsabilização das plataformas e proteção da liberdade de expressão continua a ser um desafio regulatório complexo.

A IA pode ser utilizada para combater a própria desinformação que ajuda a criar?

Sim, existem aplicações promissoras de IA no combate à desinformação, incluindo sistemas de verificação automatizada de factos, deteção de deepfakes e análise de padrões de disseminação de conteúdos falsos. Contudo, estas ferramentas enfrentam limitações significativas, particularmente na deteção de nuances contextuais e na avaliação de conteúdos em línguas menos representadas nos dados de treino.

Como posso proteger-me contra técnicas de persuasão digital baseadas em IA?

Diversificar fontes de informação, questionar conteúdos que provocam reações emocionais fortes, verificar factos antes de partilhar, e compreender como os algoritmos das plataformas que utiliza funcionam são estratégias fundamentais. Adicionalmente, ferramentas como extensões de navegador que revelam a origem política de fontes ou que alertam para websites conhecidos por desinformação podem complementar estas práticas.

A polarização digital é irreversível ou existem estratégias eficazes para a mitigar?

A investigação sugere que a polarização não é irreversível. Estratégias promissoras incluem plataformas desenhadas para promover diálogo construtivo entre perspetivas diversas, intervenções que aumentam a consciência sobre o funcionamento de algoritmos de recomendação, e iniciativas de “despolarização” baseadas em valores partilhados e objetivos comuns que transcendem divisões ideológicas.

8. Glossário de Termos Técnicos

Algoritmo de Recomendação: Sistema computacional que seleciona e prioriza conteúdos para utilizadores individuais com base em dados comportamentais, preferências inferidas e objetivos de otimização da plataforma.

Astroturfing: Prática de criar a falsa impressão de apoio popular espontâneo a uma ideia, produto ou entidade, tipicamente através de atividades coordenadas que simulam movimentos genuínos.

Câmara de Eco: Ambiente informativo onde crenças são amplificadas ou reforçadas pela comunicação repetida dentro de um sistema fechado que isola os utilizadores de perspetivas contraditórias.

Deepfake: Conteúdo audiovisual sintético criado com técnicas de inteligência artificial, tipicamente para simular pessoas reais dizendo ou fazendo coisas que nunca ocorreram.

Filter Bubble: Conceito que descreve como algoritmos de personalização isolam utilizadores em ambientes informativos que reforçam as suas próprias crenças e preferências, limitando a exposição a perspetivas contraditórias.

Microtargeting: Estratégia de marketing ou persuasão que utiliza dados detalhados sobre indivíduos para segmentar mensagens altamente personalizadas para grupos específicos.

Polarização Afetiva: Fenómeno onde indivíduos desenvolvem antipatia e desconfiança em relação a membros de grupos políticos opostos, transcendendo discordâncias sobre políticas específicas.

Redes Adversariais Generativas (GANs): Classe de algoritmos de IA onde duas redes neurais competem entre si, uma gerando conteúdo e outra avaliando a sua autenticidade, resultando em outputs progressivamente mais realistas.

Referências

Cadwalladr, C., & Graham‑Harrison, E. (2018, 17 de março). Revealed: 50 million Facebook profiles harvested for Cambridge Analytica in major data breach. The Guardian.

Pariser, E. (2011). The filter bubble: What the Internet is hiding from you. Penguin Press.

AlgorithmWatch. (2024, 23 de dezembro). A year of challenging choices – 2024 in review. AlgorithmWatch Blog.

Este artigo foi publicado originalmente em 17 de junho de 2025 e será atualizado periodicamente para refletir novas técnicas e estudos de caso.

Partilhe este artigo para promover a literacia mediática e contribuir para um ecossistema informativo mais saudável. Subscreva a nossa newsletter para receber atualizações sobre este e outros temas relacionados com comunicação política e inteligência artificial.

Como avalia a sua própria resiliência face às técnicas de persuasão digital discutidas neste artigo? Partilhe as suas reflexões nos comentários abaixo.

Meta descrição: Descubra como a inteligência artificial está a transformar as técnicas de persuasão e desinformação digital, comparando com métodos históricos de propaganda.

Palavras-chave:

Persuasão digital, Inteligência artificial e propaganda, Microtargeting político, Desinformação algorítmica, Deepfakes, IA e manipulação psicológica, Algoritmos de recomendação, Câmara de eco digital, Literacia mediática, Comunicação política digital, Engenharia social digital, Polarização nas redes sociais.

Este artigo faz parte de uma série sobre a propaganda nazi e as suas implicações contemporâneas, desenvolvida como parte do meu projeto final de pós-graduação em Comunicação e Inteligência Artificial na Universidade Católica Portuguesa.

Deixe um comentário