Introdução: A Transformação Digital da Comunicação Política

Numa manhã de janeiro de 2024, milhões de eleitores americanos receberam uma chamada telefónica aparentemente do presidente Joe Biden, anunciando que não deveriam comparecer às primárias de New Hampshire. A voz era inconfundivelmente a de Biden — exceto que não era. Tratava-se de um deepfake gerado por inteligência artificial, uma sofisticada manipulação digital criada para suprimir o voto. Este incidente, longe de ser isolado, representa apenas a ponta visível de uma transformação profunda na comunicação política contemporânea: a convergência entre propaganda e inteligência artificial.

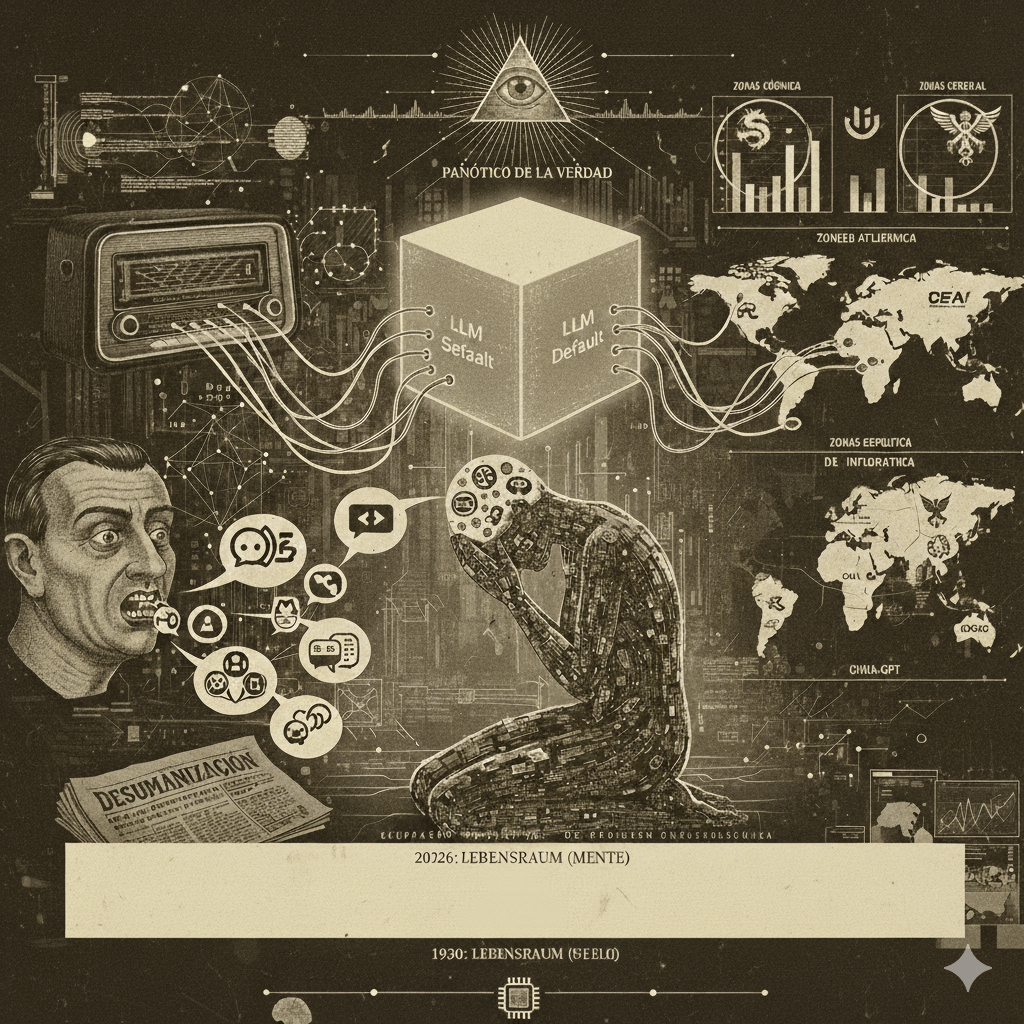

A história da propaganda política é tão antiga quanto a própria política. No entanto, estamos a testemunhar uma revolução sem precedentes na forma como as mensagens políticas são criadas, disseminadas e consumidas. As ferramentas digitais – particularmente as redes sociais e, mais recentemente, a inteligência artificial – estão a remodelar fundamentalmente o ecossistema informacional, criando tanto oportunidades para envolvimento democrático quanto riscos inéditos de manipulação psicológica em massa.

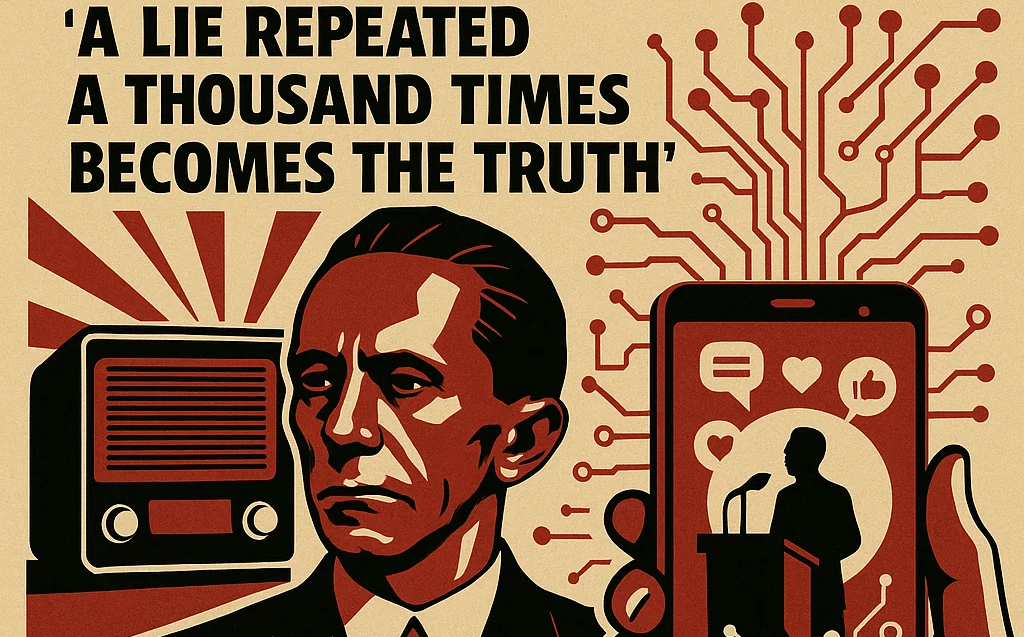

Esta dualidade evoca paralelos históricos inquietantes. Quando Joseph Goebbels, Ministro da Propaganda do Terceiro Reich, declarou que “uma mentira repetida mil vezes torna-se verdade”, não poderia imaginar um mundo onde algoritmos personalizados pudessem determinar exatamente quais “verdades” cada cidadão veria, nem quantas vezes estas seriam repetidas para maximizar a persuasão. O Volksempfänger (rádio do povo) – aparelho económico desenvolvido sob ordens de Goebbels para garantir que a propaganda nazi alcançasse todos os lares alemães – parece primitivo quando comparado com smartphones que analisam comportamentos, emoções e vulnerabilidades psicológicas em tempo real.

No entanto, apesar das diferenças tecnológicas abismais, persistem continuidades perturbadoras nas técnicas psicológicas fundamentais: a exploração de medos coletivos, a criação de inimigos comuns, a simplificação de questões complexas e a repetição incessante de narrativas emocionalmente carregadas. A diferença crucial reside na precisão, escala e personalização que as tecnologias digitais permitem. Se a propaganda tradicional era uma espingarda, atingindo amplas audiências com a mesma mensagem, a propaganda algorítmica é um sniper de precisão, calibrado para atingir cada indivíduo com a mensagem exatamente formulada para ressoar com suas predisposições psicológicas específicas.

Este artigo propõe-se a analisar criticamente esta transformação digital da propaganda política, traçando paralelos entre técnicas históricas e inovações contemporâneas, examinando como a inteligência artificial está a revolucionar a comunicação política, e discutindo os riscos psicológicos e democráticos emergentes. Mais importante, procura identificar estratégias de resiliência cívica e literacia mediática que possam fortalecer a autonomia cognitiva dos cidadãos face a estas novas formas de manipulação.

A compreensão destes mecanismos não é meramente académica; é um imperativo democrático. Numa era onde algoritmos podem determinar quais as informações que recebemos, quais as emoções que são ativadas e, potencialmente, quais as decisões que tomamos, a capacidade de reconhecer e resistir à manipulação torna-se tão fundamental para a cidadania quanto o próprio direito de voto. Como observou o historiador Timothy Snyder, “abandonar factos é abandonar liberdade” – uma advertência que adquire urgência renovada quando confrontada com tecnologias capazes de personalizar “factos” para cada cidadão.

À medida que avançamos nesta análise, torna-se evidente que o desafio fundamental permanece essencialmente humano, apesar da sofisticação tecnológica crescente: como preservar a autonomia individual e a deliberação democrática num ambiente informacional cada vez mais moldado por algoritmos otimizados não para verdade ou bem comum, mas para compromisso e persuasão? A resposta a esta questão determinará, em grande medida, o futuro das nossas democracias na era digital.

II. Do Rádio à Inteligência Artificial: Evolução da Propaganda

Propaganda Tradicional: Lições da História

A compreensão da propaganda digital contemporânea exige um olhar retrospetivo para os seus antecedentes históricos. Poucos regimes compreenderam tão profundamente o poder da comunicação de massas quanto a Alemanha Nazi, que elevou a propaganda a uma ciência de manipulação psicológica sistemática.

O Rádio como Ferramenta de Propaganda Nazi

Em 1933, quando os nazis chegaram ao poder, o rádio era o meio de comunicação mais avançado da época – o equivalente tecnológico das redes sociais atuais. Joseph Goebbels, com notável perspicácia mediática, reconheceu imediatamente o seu potencial sem precedentes. “O rádio pertence-nos”, declarou. “E nenhum outro meio pode substituí-lo.”

O regime nazi implementou uma estratégia abrangente para explorar este potencial. O Volksempfänger (“rádio do povo”), um rádio económico desenvolvido por ordem de Goebbels, foi produzido em massa para garantir que a propaganda alcançasse todos os lares alemães. O modelo mais básico, o VE 301 (nomeado para comemorar 30 de janeiro de 1933, data da ascensão de Hitler ao poder), custava apenas 76 marcos – aproximadamente um terço do preço de outros rádios disponíveis – tornando-o acessível mesmo para famílias de baixo rendimento.

Esta democratização tecnológica tinha um propósito claro: criar uma experiência nacional sincronizada. Quando Hitler discursava, milhões de alemães ouviam simultaneamente, criando um sentimento poderoso de comunidade nacional (Volksgemeinschaft). Como observou o historiador Richard Evans, “pela primeira vez na história alemã, a propaganda política podia alcançar diretamente o indivíduo, ultrapassando as instituições intermediárias da sociedade civil”.

Particularmente revelador é como o regime controlava não apenas o conteúdo, mas também o contexto de receção. Em fábricas e espaços públicos, altifalantes transmitiam discursos importantes, tornando a audição coletiva obrigatória. Esta dimensão comunitária forçada da propaganda – ouvir em grupo, observar as reações dos outros, sentir a pressão social para conformidade – tem paralelos inquietantes com as dinâmicas contemporâneas de viralização em redes sociais.

Cinema e Propaganda Visual no Terceiro Reich

Se o rádio permitia controlar o que os alemães ouviam, o cinema permitia controlar o que viam. “O filme é uma das armas mais modernas e científicas na guerra pela mentalidade das pessoas”, afirmou Goebbels, que supervisionava pessoalmente a indústria cinematográfica alemã através da Reichsfilmkammer (Câmara de Cinema do Reich).

O exemplo mais emblemático desta abordagem é “Triumph des Willens” (“O Triunfo da Vontade“, 1935), realizado por Leni Riefenstahl. Este documentário sobre o comício de Nuremberga de 1934 revolucionou a linguagem cinematográfica para fins propagandísticos, utilizando ângulos de câmara inovadores, montagem rítmica e música para criar uma experiência quase religiosa de devoção ao Führer. Significativamente, o filme raramente menciona explicitamente ideologia – em vez disso, cria uma experiência emocional avassaladora, demonstrando como a propaganda mais eficaz frequentemente opera abaixo do nível de argumentação consciente.

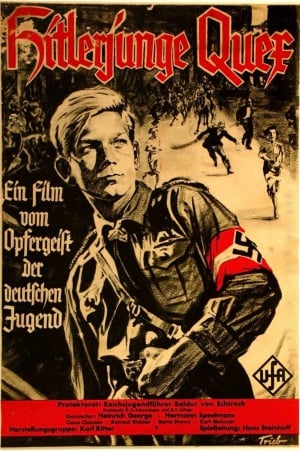

Além dos documentários explicitamente políticos, o regime produziu numerosos filmes de entretenimento aparentemente apolíticos que subtilmente reforçavam valores nazis. Filmes como “Hitlerjunge Quex” (1933) e “Jud Süß” (1940) incorporavam mensagens

ideológicas em narrativas emocionalmente envolventes, exemplificando o que poderíamos chamar de “propaganda por imersão” – técnica que encontra paralelos perturbadores nas estratégias contemporâneas de desinformação que misturam factos, ficção e entretenimento.

Técnicas Psicológicas Clássicas

Subjacentes a estas inovações tecnológicas estavam princípios psicológicos que permanecem relevantes na era digital:

- Simplificação e repetição: Goebbels compreendia que mensagens complexas eram ineficazes para comunicação de massas. “A propaganda deve limitar-se a poucos pontos e repeti-los incessantemente”, escreveu. Esta técnica – reduzir questões complexas a slogans simples repetidos ad nauseam – permanece fundamental na comunicação política digital.

- Apelo emocional sobre racional: A propaganda nazi raramente envolvia argumentação sofisticada; em vez disso, apelava diretamente a emoções básicas – medo, orgulho, ressentimento. Como observou Hitler em “Mein Kampf”: “A recetividade das grandes massas é muito limitada, sua inteligência pequena, mas seu poder de esquecimento é enorme. Consequentemente, toda propaganda eficaz deve limitar-se a muito poucos pontos e martelá-los com slogans até que o último membro do público entenda.”

- Criação de inimigos: A propaganda nazi dependia fortemente da identificação de “inimigos” – particularmente judeus, comunistas e “plutocratas ocidentais” – contra os quais a identidade alemã podia ser definida. Esta técnica de polarização e demonização do “outro” ressoa claramente nas táticas de divisão observadas em campanhas digitais contemporâneas.

- Exploração de crises: O regime nazi explorava sistematicamente crises reais ou percebidas para justificar medidas extremas e silenciar dissidência. O incêndio do Reichstag em 1933, por exemplo, foi imediatamente instrumentalizado para suspender liberdades civis e perseguir opositores políticos – uma técnica que encontra paralelos em como crises contemporâneas são frequentemente exploradas para manipulação informacional.

Transição para a Era Digital

A transição da propaganda tradicional para a digital não ocorreu abruptamente, mas através de estágios evolutivos que gradualmente transformaram tanto as tecnologias quanto as técnicas de persuasão política.

Web 1.0 e Primeiras Campanhas Digitais

A primeira fase da propaganda digital, durante a era da Web 1.0 (aproximadamente 1990-2005), caracterizava-se principalmente pela migração de formatos tradicionais para ambientes online. Websites de campanhas políticas funcionavam essencialmente como brochuras digitais, oferecendo informações estáticas com interatividade limitada.

A campanha presidencial de Howard Dean em 2004 nos Estados Unidos marcou uma viragem significativa, utilizando blogs e fóruns online para mobilização descentralizada de apoiantes. No entanto, estas primeiras iniciativas digitais ainda operavam dentro de um paradigma de comunicação relativamente unidirecional, com mensagens padronizadas dirigidas a audiências amplas – mais próximo do modelo de “transmissão” da propaganda tradicional do que do microtargeting algorítmico que viria a seguir.1

Redes Sociais e a Personalização da Propaganda

A emergência das redes sociais – particularmente após 2008, quando a campanha de Barack Obama demonstrou o seu potencial para mobilização política – inaugurou uma nova era de propaganda personalizada. Pela primeira vez, campanhas políticas podiam segmentar mensagens para audiências específicas com precisão sem precedentes, baseando-se em dados demográficos, comportamentais e psicográficos.

Esta capacidade de personalização representou uma rutura fundamental com a propaganda tradicional. Enquanto Goebbels precisava de criar mensagens que ressoassem com milhões de alemães simultaneamente, estrategistas digitais contemporâneos podem criar milhares de variações de mensagens, cada uma otimizada para ressoar com segmentos específicos do eleitorado.

A campanha de reeleição de Obama em 2012 exemplificou esta abordagem, utilizando análise de dados para identificar eleitores indecisos e personalizar mensagens baseadas nos seus interesses específicos. No entanto, estas técnicas ainda dependiam principalmente de dados demográficos e comportamentais relativamente básicos, sem a sofisticação psicológica que caracterizaria a próxima fase.

Big Data e Microtargeting: A Viragem Algorítmica

O verdadeiro salto qualitativo na propaganda digital ocorreu com a convergência de três desenvolvimentos: a explosão de dados comportamentais disponíveis, o refinamento de algoritmos de aprendizagem automática, e a aplicação de insights da psicologia comportamental ao marketing político.

O caso Cambridge Analytica, que veio à luz em 2018, ilustra esta convergência. A empresa alegadamente utilizou dados de milhões de utilizadores do Facebook para construir perfis psicológicos detalhados, permitindo microtargeting de mensagens políticas baseadas não apenas em características demográficas, mas em traços de personalidade e vulnerabilidades psicológicas específicas.

Independentemente das controvérsias sobre a eficácia real das técnicas da Cambridge Analytica, o caso revelou um novo paradigma de propaganda: a “persuasão algorítmica” – utilização de inteligência artificial para identificar precisamente quais mensagens têm maior probabilidade de influenciar indivíduos específicos, baseando-se em modelos psicológicos cada vez mais sofisticados.

Esta abordagem representa uma inversão fundamental da lógica tradicional da propaganda. Em vez de criar uma mensagem persuasiva e depois disseminá-la amplamente, a propaganda algorítmica começa analisando o alvo para depois gerar mensagens personalizadas otimizadas para sua persuasão específica.

Continuidades Psicológicas e Rupturas Tecnológicas

Apesar das transformações tecnológicas radicais, persistem continuidades significativas entre propaganda tradicional e digital, particularmente nos mecanismos psicológicos explorados.

Técnicas que Persistem

- Polarização e criação de inimigos: Assim como a propaganda nazi explorava e amplificava divisões sociais existentes, algoritmos contemporâneos frequentemente otimizam para conteúdo divisivo que reforça identidades grupais através da oposição a “inimigos” percebidos. Estudos demonstram que conteúdo que provoca indignação moral recebe significativamente mais engajamento nas redes sociais, criando incentivo estrutural para polarização.

- Repetição e consistência: O princípio de Goebbels sobre repetição incessante encontra expressão digital na capacidade de algoritmos para expor utilizadores repetidamente a mensagens similares através de múltiplos canais, criando ilusão de consenso e normalidade – o que psicólogos chamam de “efeito de verdade ilusória”.

- Exploração de crises: Tanto propaganda tradicional quanto digital prosperam em momentos de incerteza e medo. A diferença crucial é a velocidade: enquanto Goebbels precisava de dias para desenvolver narrativas em resposta a eventos, sistemas contemporâneos podem gerar e testar múltiplas narrativas em questão de horas ou mesmo minutos.

- Apelo a emoções básicas: A propaganda digital, como sua antecessora tradicional, continua priorizando apelos emocionais sobre argumentação racional. A diferença é a precisão: algoritmos podem identificar exatamente quais gatilhos emocionais funcionam melhor para cada indivíduo.

Inovações Digitais

Apesar destas continuidades, a propaganda digital introduz capacidades fundamentalmente novas:

- Personalização em massa: A capacidade de personalizar mensagens para milhões de indivíduos simultaneamente representa uma rutura fundamental com a propaganda tradicional, que necessariamente operava com mensagens padronizadas para audiências amplas.

- Adaptação em tempo real: Sistemas contemporâneos podem monitorar respostas e ajustar mensagens dinamicamente, criando ciclos de feedback que otimizam continuamente para persuasão – algo inimaginável na era da propaganda tradicional.

- Exploração de vulnerabilidades psicológicas específicas: Enquanto propaganda tradicional explorava vulnerabilidades psicológicas generalizadas, sistemas algorítmicos podem identificar e explorar vulnerabilidades específicas de indivíduos ou pequenos grupos.

- Camuflagem da fonte: A propaganda digital pode ocultar sua origem muito mais eficazmente que a tradicional, operando através de redes de contas falsas, bots e sites aparentemente independentes que criam ilusão de consenso espontâneo.

Diferenças Fundamentais na Escala e Precisão

A diferença mais significativa entre propaganda tradicional e digital não reside nos princípios psicológicos fundamentais explorados, mas na escala, precisão e adaptabilidade com que podem ser aplicados.

O Ministério da Propaganda de Goebbels empregava aproximadamente 1.000 funcionários em 1933, crescendo para cerca de 2.000 no auge da guerra. Em contraste, sistemas algorítmicos contemporâneos podem analisar comportamentos de bilhões de utilizadores, gerar e testar milhões de variações de mensagens, e otimizar continuamente para persuasão – tudo com mínima intervenção humana.

Esta automação da persuasão representa talvez a rutura mais profunda com a propaganda tradicional. Como observou o investigador Zeynep Tufekci, “estamos a construir uma infraestrutura de persuasão que pode ser utilizada por qualquer pessoa com acesso a ela, e estamos a fazê-lo sem compreender plenamente como funciona ou quais serão suas consequências”.

À medida que avançamos para a era da inteligência artificial generativa, esta infraestrutura torna-se simultaneamente mais poderosa e mais acessível, democratizando capacidades de manipulação anteriormente limitadas a estados e grandes corporações. Esta convergência entre propaganda e inteligência artificial tema da próxima secção – representa tanto o culminar lógico desta evolução quanto um salto qualitativo para território largamente inexplorado.

III. Como a IA Transforma a Comunicação Política

A convergência entre inteligência artificial e comunicação política representa uma revolução silenciosa mas profunda na forma como mensagens políticas são criadas, disseminadas e consumidas. Se a era das redes sociais introduziu a capacidade de segmentação e personalização, a era da IA amplifica estas capacidades exponencialmente, introduzindo níveis de sofisticação, automação e persuasão anteriormente inimagináveis.

Microtargeting Comportamental

Coleta e Análise de Dados Comportamentais

O microtargeting político não é inteiramente novo — campanhas sempre procuraram segmentar mensagens para diferentes grupos demográficos. No entanto, a IA transformou fundamentalmente a escala e precisão desta prática.

Sistemas contemporâneos de microtargeting político não se limitam a dados demográficos básicos (idade, género, localização), mas incorporam vastos conjuntos de dados comportamentais: históricos de navegação, interações em redes sociais, compras online, aplicações utilizadas, padrões de movimento geográfico e inúmeras outras “pegadas digitais” que deixamos constantemente.

Algoritmos de aprendizagem profunda podem analisar estes dados para identificar padrões que seriam impossíveis de detetar para analistas humanos. Por exemplo, um estudo da Universidade de Cambridge demonstrou que algoritmos podem prever traços de personalidade com maior precisão que familiares próximos analisando apenas 300 likes no Facebook. Outro estudo publicado na PNAS (Proceedings of the National Academy of Sciences) revelou que IA pode prever orientações políticas com 80-90% de precisão baseando-se apenas em padrões de linguagem em redes sociais.

Esta capacidade de inferência psicológica automatizada representa uma rutura fundamental com práticas anteriores de segmentação política. Como observou o investigador Michal Kosinski, cujo trabalho foi posteriormente adaptado pela Cambridge Analytica: “Estamos a construir sistemas que conhecem os humanos melhor que eles próprios.”

Segmentação Psicográfica e Demográfica

O verdadeiro poder do microtargeting baseado em IA reside na capacidade de segmentar não apenas por características demográficas ou comportamentos observáveis, mas por perfis psicológicos detalhados — o que marketers chamam de “psicografia”.

Sistemas contemporâneos podem categorizar eleitores baseando-se em traços de personalidade (utilizando modelos como o Big Five: abertura, conscienciosidade, extroversão, amabilidade e neuroticismo), valores morais (utilizando estruturas como a Teoria dos Fundamentos Morais de Jonathan Haidt), e vulnerabilidades psicológicas específicas.

Esta segmentação psicográfica permite que campanhas adaptem mensagens não apenas ao que os eleitores pensam sobre determinadas questões, mas a como pensam — quais valores morais priorizam, quais emoções são mais facilmente despertadas, e quais estruturas argumentativas são mais persuasivas para diferentes personalidades.

Por exemplo, uma campanha poderia apresentar a mesma política ambiental de formas radicalmente diferentes: enfatizando pureza e santidade da natureza para eleitores que pontuam alto em fundamentos morais conservadores; destacando justiça intergeracional para eleitores com orientação progressista; ou focando em eficiência económica para eleitores com personalidades mais analíticas.

Casos de Estudo: Cambridge Analytica e Além

O caso Cambridge Analytica, que veio à luz em 2018, oferece um vislumbre das capacidades e controvérsias do microtargeting político baseado em IA. A empresa alegadamente utilizou dados de 87 milhões de utilizadores do Facebook, combinados com modelos psicológicos, para criar perfis detalhados que permitiam microtargeting de mensagens políticas durante a campanha presidencial americana de 2016 e o referendo do Brexit.

Embora o impacto real das técnicas da Cambridge Analytica permaneça debatido entre especialistas, o caso revelou ao público a existência de uma infraestrutura de persuasão algorítmica operando largamente sem supervisão ou compreensão pública.

Desde então, estas técnicas tornaram-se mais sofisticadas e generalizadas. Na campanha presidencial brasileira de 2022, investigadores documentaram uso extensivo de microtargeting algorítmico em plataformas como WhatsApp e Telegram, com mensagens personalizadas baseadas em perfis psicológicos e regionais. Na Índia, as eleições de 2024 viram implementação de “war rooms” de IA que analisavam dados comportamentais em tempo real para ajustar estratégias de comunicação.

Significativamente, estas técnicas estão a tornar-se acessíveis não apenas para grandes campanhas nacionais, mas para atores políticos de todos os níveis. Plataformas como NationBuilder, Aristotle e i360 oferecem capacidades de microtargeting baseado em IA para campanhas locais com orçamentos relativamente modestos, democratizando ferramentas anteriormente disponíveis apenas para operações sofisticadas.

Chatbots e Deepfakes

Tecnologia por Trás dos Deepfakes Políticos

Os deepfakes representam talvez a face mais visível e inquietante da IA na comunicação política. Estas manipulações audiovisuais hiper-realistas utilizam redes adversariais generativas (GANs) e, mais recentemente, modelos difusivos, para criar, modificar ou sintetizar conteúdo que parece autêntico mas é fabricado.

A tecnologia evoluiu rapidamente desde 2017, quando os primeiros deepfakes amadores surgiram. Os sistemas atuais podem gerar vídeos falsos fotorrealistas com mínimo material de referência, sincronizar perfeitamente movimentos labiais com áudio sintético, e até recriar maneirismos específicos de figuras públicas.

Particularmente significativo é o desenvolvimento de modelos multimodais como GPT-4 e Claude 3, que podem gerar texto, imagem e áudio coerentes entre si, facilitando a criação de narrativas falsas completas e internamente consistentes. A barreira técnica para criação de deepfakes convincentes diminui constantemente, com ferramentas como EbSynth, Synthesia e D-ID tornando a tecnologia acessível mesmo para utilizadores sem conhecimentos técnicos avançados.

Exemplos Recentes de Manipulação Audiovisual

Os casos documentados de deepfakes em comunicação política multiplicam-se rapidamente:

- Em janeiro de 2024, um deepfake de áudio do presidente Biden circulou em New Hampshire, instruindo eleitores democratas a não votarem nas primárias — um exemplo claro de supressão de voto através de manipulação digital.

- Durante as eleições presidenciais eslovacas de 2023, deepfakes de áudio do candidato Michal Šimečka circularam no WhatsApp dias antes da votação, mostrando-o supostamente a discutir fraude eleitoral e aumento de preços.

- Na Índia, deepfakes de políticos falando em dialetos regionais que não dominam tornaram-se ferramentas comuns para alcançar eleitores em áreas linguisticamente diversas.

- Em Portugal, durante as eleições legislativas de 2025, circularam vídeos manipulados mostrando candidatos a fazer declarações inflamatórias sobre imigração e políticas económicas.

Além destes casos de manipulação explícita, emerge uma categoria mais subtil: os “cheapfakes” — manipulações tecnicamente simples como vídeos descontextualizados, editados seletivamente ou ligeiramente alterados para mudar seu significado. Embora menos sofisticados tecnicamente que deepfakes, podem ser igualmente enganosos e frequentemente mais difíceis de detetar automaticamente.

Impacto na Perceção da Realidade Política

O impacto dos deepfakes vai além dos casos específicos de desinformação. Sua mera existência cria o que investigadores chamam de “efeito liar’s dividend” — a capacidade de figuras públicas desacreditarem gravações autênticas alegando que são falsificações.

Este fenómeno foi observado em múltiplos contextos políticos recentes, onde gravações comprometedoras foram descartadas como “deepfakes” mesmo quando eram autênticas. A erosão resultante da confiança em evidência audiovisual — historicamente considerada altamente confiável — representa uma transformação profunda no ecossistema informacional.

Estudos psicológicos sugerem que mesmo após correção, deepfakes podem deixar “resíduos cognitivos” — impressões persistentes que influenciam julgamentos subsequentes. Um estudo da Universidade de Amsterdam demonstrou que participantes expostos a deepfakes políticos, mesmo quando posteriormente informados sobre sua falsidade, mantinham atitudes influenciadas pelo conteúdo falso.

Particularmente preocupante é o potencial para “cascatas informacionais” onde deepfakes são amplificados por redes de bots e contas automatizadas, criando ilusão de consenso ou controvérsia generalizada antes que verificadores de factos possam responder.

Análise de Sentimento e Modelagem Preditiva

Monitoramento em Tempo Real da Opinião Pública

A inteligência artificial transformou fundamentalmente como campanhas políticas monitoram e respondem à opinião pública. Sistemas contemporâneos de análise de sentimento podem processar milhões de publicações em redes sociais, comentários, artigos de notícias e outras fontes textuais em tempo real, extraindo não apenas temas gerais mas nuances emocionais específicas.

Estes sistemas vão além da simples classificação binária (positivo/negativo), identificando emoções específicas como raiva, medo, entusiasmo ou desconfiança. Algoritmos de processamento de linguagem natural (PLN) como BERT, GPT e outros modelos transformers podem detetar subtexto, sarcasmo e conotações culturais que escapariam a análises mais básicas.

Campanhas políticas utilizam estas ferramentas para monitoramento contínuo do “pulso” do eleitorado, identificando mudanças subtis em sentimento público muito antes que apareçam em pesquisas tradicionais. Por exemplo, durante debates presidenciais recentes, equipas de campanha utilizaram análise de sentimento em tempo real para ajustar mensagens subsequentes baseadas em reações do público a argumentos específicos.

Particularmente significativa é a capacidade de segmentar esta análise geograficamente e demograficamente, permitindo que campanhas identifiquem como diferentes mensagens ressoam com segmentos específicos do eleitorado em diferentes regiões.

Previsão de Reações a Mensagens Políticas

Além de analisar reações existentes, sistemas de IA contemporâneos podem prever como diferentes audiências responderão a mensagens específicas antes de sua disseminação.

Modelos preditivos treinados em vastos conjuntos de dados comportamentais podem simular reações prováveis de diferentes segmentos demográficos e psicográficos a mensagens políticas específicas. Estes “gémeos digitais” do eleitorado permitem que estrategistas testem múltiplas abordagens comunicativas em ambiente virtual antes de implementá-las no mundo real.

Por exemplo, uma campanha pode utilizar estes modelos para prever como eleitores em regiões específicas responderão a diferentes enquadramentos de uma política económica, ou como diferentes grupos etários reagirão a ataques contra oponentes.

Esta capacidade preditiva representa uma transformação fundamental na comunicação política: em vez de reagir a feedback do público após disseminação de mensagens, campanhas podem otimizar comunicações antecipadamente baseadas em simulações algorítmicas de reações públicas.

Adaptação Dinâmica de Narrativas

A convergência entre análise de sentimento em tempo real e modelagem preditiva permite que campanhas políticas implementem “narrativas adaptativas” — estruturas comunicativas que evoluem dinamicamente baseadas em feedback contínuo.

Em contraste com campanhas tradicionais organizadas em torno de mensagens centrais relativamente estáticas, campanhas potenciadas por IA podem ajustar continuamente enquadramentos, ênfases e até posições políticas baseadas em análise algorítmica de sua eficácia persuasiva.

Esta adaptabilidade manifesta-se em múltiplos níveis: desde ajustes táticos em tempo real durante eventos mediáticos até evoluções estratégicas de narrativas de campanha ao longo de semanas ou meses. O resultado é uma comunicação política que se comporta menos como mensagem pré-determinada e mais como organismo evolutivo, adaptando-se continuamente ao ambiente informacional.

Adaptação de Conteúdo em Tempo Real

Personalização Algorítmica de Mensagens

A personalização de mensagens políticas atingiu níveis de granularidade sem precedentes com sistemas de IA contemporâneos. Enquanto campanhas tradicionais podiam segmentar mensagens para alguns poucos grupos demográficos amplos, sistemas atuais podem gerar variações quase infinitas de mensagens otimizadas para perfis individuais específicos.

Esta hiperpersonalização opera em múltiplos níveis:

- Conteúdo substantivo: Enfatizando diferentes aspetos de políticas baseados em interesses inferidos do eleitor

- Enquadramento emocional: Ajustando tom e apelo emocional baseado em perfil psicológico

- Elementos visuais: Selecionando imagens e estética que ressoam com preferências estéticas individuais

- Estrutura argumentativa: Adaptando entre argumentos baseados em autoridade, emoção ou lógica dependendo do perfil cognitivo do recetor

Significativamente, esta personalização frequentemente ocorre sem conhecimento consciente do recetor. Utilizadores de plataformas digitais raramente percebem o grau em que conteúdo político que encontram foi algoritmicamente otimizado para seu perfil específico.

A/B Testing em Comunicação Política

O teste A/B — comparação sistemática de diferentes versões de conteúdo para determinar qual gera resposta mais favorável — tornou-se fundamental para comunicação política digital. Sistemas de IA elevaram esta prática a novos níveis de sofisticação e escala.

Campanhas contemporâneas frequentemente testam dezenas ou centenas de variações de mensagens simultaneamente, com algoritmos identificando automaticamente quais combinações de imagens, textos, apelos emocionais e enquadramentos geram maior engajamento para diferentes segmentos do eleitorado.

Este processo ocorre com velocidade e escala impossíveis para análise humana. Por exemplo, durante eleições recentes, investigadores documentaram campanhas testando mais de 100.000 variações de anúncios políticos em questão de dias, com algoritmos continuamente otimizando baseados em métricas de engajamento.

Particularmente significativa é a evolução de testes A/B simples para “testes multivariados” mais sofisticados, onde algoritmos podem identificar interações complexas entre múltiplos elementos de mensagens políticas e características específicas de audiências.

Otimização para Envolvimento Emocional

Talvez o aspeto mais consequente da adaptação algorítmica de conteúdo seja sua otimização para engajamento emocional específico. Sistemas de IA contemporâneos podem identificar precisamente quais gatilhos emocionais são mais eficazes para diferentes indivíduos e contextos.

Esta capacidade baseia-se em compreensão algorítmica cada vez mais sofisticada de psicologia humana. Por exemplo, sistemas podem identificar se um eleitor específico responde mais fortemente a mensagens que provocam indignação moral, medo de perdas, esperança por mudança, ou nostalgia por um passado idealizado.

Significativamente, esta otimização frequentemente favorece emoções negativas como raiva, medo e indignação, que tipicamente geram maior engajamento online. Estudos do MIT Media Lab demonstraram que conteúdo político provocando indignação moral espalha-se aproximadamente 20% mais rapidamente em redes sociais que conteúdo emocionalmente neutro ou positivo.

O resultado é um ecossistema informacional onde algoritmos inadvertidamente favorecem conteúdo político mais polarizante e emocionalmente manipulativo — não necessariamente por design intencional, mas como consequência emergente da otimização para engajamento.

Implicações para o Discurso Democrático

A convergência entre inteligência artificial e comunicação política levanta questões fundamentais sobre o futuro do discurso democrático. Se democracia depende de cidadãos capazes de formar julgamentos autónomos baseados em informação compartilhada, estas tecnologias apresentam desafios sem precedentes.

Particularmente preocupante é a assimetria informacional entre cidadãos e sistemas algorítmicos que moldam crescentemente seu ambiente informacional. Como observou o filósofo político Philip Pettit, liberdade democrática requer não apenas ausência de interferência direta, mas ausência de “dominação” — capacidade de outros interferirem arbitrariamente sem accountability.

Sistemas de IA que podem prever e manipular comportamento político sem transparência ou consentimento informado representam potencialmente nova forma de dominação — não através de coerção explícita, mas através de arquitetura informacional que molda impercetivelmente perceções e escolhas.

Simultaneamente, estas mesmas tecnologias oferecem potencial para engajamento democrático mais inclusivo e responsivo. Sistemas de IA podem ajudar cidadãos a navegar ecossistemas informacionais complexos, identificar desinformação, e participar mais efetivamente em processos democráticos.

O desafio fundamental, portanto, não é simplesmente resistir a estas tecnologias, mas governá-las democraticamente — assegurando que sirvam valores democráticos de autonomia, igualdade e deliberação informada, em vez de miná-los. Este desafio de governança democrática da IA na esfera pública representa uma das questões mais urgentes para democracias contemporâneas.

IV. Riscos Psicológicos e Democráticos

A convergência entre propaganda digital e inteligência artificial não representa apenas uma evolução tecnológica, mas uma transformação fundamental no ecossistema informacional que sustenta democracias. Esta transformação traz consigo riscos psicológicos e democráticos profundos que merecem análise cuidadosa.

Polarização Emocional

Algoritmos de Recomendação e Radicalização

Os algoritmos que governam plataformas digitais contemporâneas são otimizados primariamente para maximizar engajamento — tempo de utilização, cliques, partilhas e comentários. Esta otimização, aparentemente neutra, tem consequências profundas para o discurso político.

Estudos empíricos demonstram consistentemente que conteúdo emocional, particularmente aquele que provoca indignação moral, medo ou ultraje, gera significativamente mais engajamento online. Um estudo abrangente do MIT Media Lab analisando milhões de publicações no Twitter (atual X) encontrou que mensagens políticas contendo indignação moral tinham aproximadamente 20% mais probabilidade de serem partilhadas, com cada termo moralmente carregado adicional aumentando a taxa de partilha em cerca de 10%.

Esta dinâmica cria o que investigadores chamam de “viés algorítmico para extremismo” — tendência de sistemas de recomendação para gradualmente expor utilizadores a conteúdo progressivamente mais extremo e emocionalmente carregado. A investigadora Zeynep Tufekci documentou este fenómeno no YouTube, onde algoritmos de recomendação consistentemente direcionavam utilizadores para conteúdo progressivamente mais radical, independentemente do ponto de partida político.

Particularmente preocupante é o potencial para “escadas de radicalização” algorítmicas, onde sistemas de recomendação inadvertidamente criam trajetórias que conduzem utilizadores de conteúdo moderado para extremo através de série de pequenos passos incrementais. O investigador Becca Lewis documentou este processo em estudo de 2018, demonstrando como algoritmos do YouTube frequentemente direcionavam espectadores de conteúdo político mainstream para criadores de conteúdo progressivamente mais extremos através de recomendações aparentemente lógicas.

Exploração de Vieses Cognitivos

A propaganda digital potenciada por IA explora sistematicamente vieses cognitivos humanos bem documentados:

- Viés de confirmação: Algoritmos identificam crenças existentes e servem conteúdo que as confirma, criando ciclos de feedback que fortalecem convicções pré-existentes independentemente de sua precisão factual. Estudos demonstram que utilizadores expostos a conteúdo algoritmicamente personalizado demonstram maior polarização de atitudes que aqueles expostos a conteúdo diversificado.

- Efeito de mera exposição: A repetição algorítmica de mensagens similares explora o fenómeno psicológico onde familiaridade aumenta credibilidade percebida. Investigadores da Universidade de Yale demonstraram que exposição repetida a afirmações falsas aumenta significativamente sua aceitação como verdadeiras, mesmo entre pessoas inicialmente céticas.

- Heurística de disponibilidade: Algoritmos que amplificam conteúdo viral tornam certas narrativas desproporcionalmente “disponíveis” mentalmente, distorcendo perceções de prevalência e importância. Estudos demonstram que exposição a conteúdo algoritmicamente selecionado leva consistentemente a sobrestimação da prevalência de eventos raros mas emocionalmente impactantes.

- Viés de negatividade: A tendência humana para dar maior peso a informações negativas é sistematicamente explorada por algoritmos que favorecem conteúdo provocador de medo, raiva e indignação. Análises de conteúdo viral em plataformas como Facebook e Twitter demonstram que publicações políticas negativas recebem aproximadamente 50% mais engajamento que publicações positivas com informação substantivamente similar.

Erosão do Diálogo Democrático

A polarização emocional algoritmicamente amplificada tem consequências diretas para capacidade de sociedades democráticas manterem diálogo construtivo sobre questões complexas.

Quando cidadãos são consistentemente expostos a versões emocionalmente intensificadas das posições políticas opostas, ocorre o que psicólogos chamam de “perceção de polarização exagerada” — tendência a ver oponentes políticos como mais extremos e hostis do que realmente são. Estudos demonstram que utilizadores frequentes de redes sociais consistentemente sobrestimam extremismo e hostilidade de oponentes políticos.

Esta perceção distorcida alimenta ciclo de hostilidade recíproca onde cada lado responde não às posições reais do outro, mas a caricaturas emocionalmente amplificadas. O resultado é erosão gradual da capacidade para deliberação democrática baseada em compreensão mútua e terreno factual compartilhado.

Particularmente preocupante é o declínio documentado na capacidade de distinguir entre desacordos factuais (sobre o que é) e desacordos normativos (sobre o que deveria ser). Estudos demonstram que utilizadores frequentes de media social algoritmicamente curada demonstram maior tendência para conflação destes dois tipos de desacordo, dificultando resolução racional de diferenças políticas.

Bolhas Informativas e Câmaras de Eco

Formação e Reforço de Bolhas Algorítmicas

O conceito de “filtro bolha”, introduzido por Eli Pariser em 2011, adquiriu nova urgência na era da IA. Algoritmos contemporâneos criam ambientes informacionais personalizados que podem isolar utilizadores de perspetivas divergentes com precisão e eficácia sem precedentes.

Estas bolhas informativas operam através de mecanismos subtis mas poderosos:

- Personalização preditiva: Algoritmos não apenas respondem a preferências explícitas, mas preveem ativamente preferências não expressas baseadas em padrões comportamentais, criando bolhas que utilizadores nunca escolheram conscientemente.

- Homofilia estrutural: Sistemas de recomendação amplificam tendência natural para homofilia (preferência por similaridade), criando redes de conexão que são significativamente mais homogéneas que interações offline.

- Invisibilidade do filtro: Ao contrário de censura explícita, filtros algorítmicos operam invisívelmente — utilizadores raramente percebem extensão em que seu ambiente informacional foi curado, criando ilusão de perspetiva completa.

Estudos empíricos confirmam impacto destas dinâmicas. Uma análise de 2023 de mais de 10 milhões de utilizadores do Twitter documentou formação de clusters ideológicos distintos com mínima exposição cruzada a conteúdo divergente. Similarmente, pesquisadores da Universidade de Stanford demonstraram que algoritmos do Facebook consistentemente reduzem exposição a conteúdo politicamente diverso em aproximadamente 15% comparado com seleção aleatória.

Fragmentação do Espaço Público Digital

A proliferação de bolhas informativas contribui para fragmentação mais ampla do espaço público digital — transformação de ágora virtual unificada em arquipélago de ilhas informacionais com mínima comunicação entre si.

Esta fragmentação manifesta-se em múltiplos níveis:

- Léxico divergente: Grupos políticos diferentes desenvolvem vocabulários especializados e enquadramentos concetuais distintos, dificultando comunicação significativa entre comunidades.

- Prioridades informacionais divergentes: Diferentes comunidades não apenas interpretam eventos diferentemente, mas frequentemente focam em conjuntos completamente diferentes de eventos e questões, criando realidades informacionais paralelas.

- Epistemologias divergentes: Mais fundamentalmente, comunidades políticas diferentes desenvolvem critérios divergentes para determinar o que constitui conhecimento confiável, minando possibilidade de acordo sobre factos básicos.

O investigador Yochai Benkler descreve este fenómeno como “fragmentação epistémica” — situação onde cidadãos não apenas discordam sobre interpretações, mas habitam realidades informacionais fundamentalmente diferentes com mínima sobreposição factual.

Comparação com Isolamento Informacional em Regimes Totalitários

Esta fragmentação algorítmica evoca paralelos inquietantes com isolamento informacional em regimes totalitários históricos, embora com diferenças cruciais.

Na Alemanha Nazi, o Ministério da Propaganda de Goebbels criava ambiente informacional hermeticamente fechado através de censura centralizada e controlo estatal de todos os meios de comunicação. Cidadãos eram forçados a consumir propaganda oficial, com acesso a fontes alternativas severamente restrito.

Em contraste, bolhas informativas contemporâneas são frequentemente auto-selecionadas e mantidas através de mecanismos descentralizados. Como observou a investigadora Danah Boyd, “as pessoas não estão sendo forçadas a ambientes informacionais homogéneos por censura governamental, mas gravitando voluntariamente para eles através de escolhas mediadas algoritmicamente.”

Esta diferença fundamental — coerção centralizada versus auto-segregação algoritmicamente facilitada — representa simultaneamente evolução mais subtil e potencialmente mais resiliente de isolamento informacional. Cidadãos em bolhas informativas contemporâneas frequentemente não percebem limitações de seu ambiente informacional e, consequentemente, não buscam ativamente alternativas.

Como observou o historiador Timothy Snyder, “o súbdito ideal do regime totalitário não é o nazi convicto… mas pessoas para quem a distinção entre facto e ficção, verdadeiro e falso, já não existe” — descrição que ressoa perturbadoramente com fragmentação epistémica contemporânea.

Normalização da Desinformação

Sobrecarga Informacional e Fadiga Cognitiva

A era digital caracteriza-se por sobrecarga informacional sem precedentes. Cidadãos contemporâneos enfrentam volume de informação que excede vastamente capacidade humana para processamento crítico, criando vulnerabilidade fundamental à desinformação.

Esta sobrecarga manifesta-se em múltiplos níveis:

- Volume puro: Utilizadores médios de redes sociais são expostos a aproximadamente 5.000 mensagens diariamente, impossibilitando avaliação crítica de cada item.

- Velocidade de circulação: Ciclos de notícias acelerados algoritmicamente reduzem drasticamente tempo disponível para verificação e reflexão antes que novas narrativas substituam anteriores.

- Complexidade crescente: Questões políticas contemporâneas frequentemente envolvem sistemas complexos (clima, economia global, pandemias) que resistem a compreensão intuitiva, criando dependência de intermediários informativos.

O resultado é o que psicólogos chamam de “fadiga cognitiva” — estado de exaustão mental que leva a processamento mais superficial e maior suscetibilidade a heurísticas simplificadoras. Estudos demonstram que indivíduos sob fadiga cognitiva são significativamente mais vulneráveis a desinformação, particularmente quando esta confirma crenças existentes.

Significativamente, sistemas de IA podem explorar esta vulnerabilidade através de “inundação informacional estratégica” — sobrecarregando deliberadamente canais informativos com volume de conteúdo que impossibilita verificação efetiva. Esta técnica, documentada em campanhas de desinformação recentes, representa evolução sofisticada da propaganda tradicional: em vez de suprimir informação indesejada, simplesmente a afoga em oceano de distração e ruído.

Erosão da Distinção entre Facto e Ficção

Talvez o risco mais profundo da propaganda potenciada por IA seja sua capacidade para borrar fundamentalmente linhas entre facto e ficção, realidade e fabricação.

Tecnologias como deepfakes, geração de texto por IA e manipulação de imagens criam conteúdo que é simultaneamente falso e convincentemente autêntico, desafiando capacidades humanas de discernimento. Estudos demonstram que mesmo indivíduos alertados sobre possibilidade de manipulação frequentemente falham em identificar conteúdo sintético sofisticado.

Esta capacidade técnica para fabricação convincente coincide com mudanças culturais e epistemológicas mais amplas:

- Relativismo epistémico: Crescente ceticismo sobre possibilidade de conhecimento objetivo, frequentemente explorado por atores políticos que deslegitimam fontes informativas inconvenientes como “fake news”.

- Fragmentação de autoridade: Declínio de gatekeepers informativos tradicionais e proliferação de fontes alternativas com padrões epistemológicos divergentes.

- Comoditização da verdade: Tratamento de afirmações factuais como ferramentas estratégicas para avançar agendas políticas em vez de descrições da realidade a serem avaliadas por padrões independentes.

O resultado é o que filósofos políticos chamam de “pós-verdade” — ambiente informacional onde apelo emocional e alinhamento com crenças pré-existentes frequentemente superam precisão factual como determinantes de aceitação. Como definido pelo Dicionário Oxford (que nomeou “pós-verdade” palavra do ano em 2016): “circunstâncias em que factos objetivos são menos influentes na formação da opinião pública do que apelos à emoção e crença pessoal.”

Paralelos com Técnicas de Propaganda Totalitária

Esta erosão da distinção entre facto e ficção evoca paralelos inquietantes com técnicas de propaganda totalitária histórica, particularmente a abordagem nazi à verdade.

Hannah Arendt, em sua análise do totalitarismo, observou que regimes totalitários não simplesmente mentiam sobre factos específicos, mas criavam sistemas completos de falsidade internamente coerentes. “O súbdito ideal do regime totalitário”, escreveu, “não é o nazi convicto ou o comunista convicto, mas pessoas para quem a distinção entre facto e ficção, verdadeiro e falso, já não existe.”

Similarmente, o historiador Timothy Snyder identifica como característica central da propaganda totalitária não simplesmente falsidade, mas ataque à própria possibilidade de verdade: “Abandonar factos é abandonar liberdade. Se nada é verdade, ninguém pode criticar o poder, porque não há base para fazê-lo.”

A diferença crucial entre propaganda totalitária histórica e contemporânea reside na estrutura: enquanto regimes totalitários impunham narrativa falsa unificada de cima para baixo, ecossistema contemporâneo de desinformação é caracterizado por proliferação de múltiplas narrativas contraditórias, criando não uma grande mentira, mas caleidoscópio de realidades alternativas parciais.

Como observou o teórico russo Peter Pomerantsev analisando técnicas contemporâneas de propaganda: “Este é o método de propaganda do século XXI. Não é tentar convencer alguém de algo. É manter as pessoas confusas, passivas, desconfiadas de todas as narrativas.”

Erosão da Confiança Pública

Impacto na Legitimidade Institucional

A convergência entre propaganda digital e IA contribui para declínio documentado na confiança em instituições democráticas fundamentais — tendência com implicações profundas para estabilidade e funcionamento de sistemas democráticos.

Dados do Edelman Trust Barometer, Pew Research Center e outras fontes documentam declínio consistente na confiança pública em instituições governamentais, media, academia e outras fontes tradicionais de autoridade epistémica ao longo da última década — período que coincide com ascensão de redes sociais algoritmicamente mediadas como fontes primárias de informação política.

Esta erosão de confiança opera através de múltiplos mecanismos:

- Amplificação seletiva de falhas: Algoritmos otimizados para engajamento amplificam desproporcionalmente falhas institucionais, criando perceção distorcida de incompetência ou corrupção generalizada.

- Descontextualização estratégica: Informação sobre instituições é frequentemente apresentada sem contexto necessário para interpretação equilibrada, facilitando enquadramentos negativos.

- Exploração de lacunas de responsabilidade: Atores mal-intencionados podem explorar lacunas reais na responsabilidade institucional para minar confiança mais ampla no sistema democrático.

- Ataques coordenados a fontes de autoridade epistémica: Campanhas sistemáticas visam especificamente deslegitimar instituições que tradicionalmente arbitram verdade factual (jornalismo profissional, academia, agências governamentais técnicas).

Particularmente preocupante é o potencial para “cascatas de desconfiança” onde ceticismo inicial sobre instituições específicas expande gradualmente para rejeição mais fundamental do sistema democrático. Estudos longitudinais documentam correlação significativa entre exposição a conteúdo algoritmicamente selecionado e declínio em confiança não apenas em instituições específicas, mas no conceito mais amplo de democracia representativa.

Cinismo Político e Apatia Cívica

A erosão de confiança institucional frequentemente manifesta-se como cinismo político generalizado — crença de que sistema político é fundamentalmente corrupto, que participação significativa é impossível, e que atores políticos invariavelmente agem por interesse próprio independentemente de retórica pública.

Este cinismo representa ameaça distinta da polarização: enquanto polarização envolve engajamento intenso (embora hostil), cinismo produz desengajamento e apatia. Estudos documentam correlação significativa entre exposição a conteúdo político algoritmicamente selecionado e aumento em atitudes cínicas, particularmente entre jovens adultos.

Particularmente preocupante é o fenómeno que cientistas políticos chamam de “cinismo assimétrico” — situação onde cidadãos mantêm engajamento suficiente para sentir ultraje sobre sistema político, mas insuficiente para participação construtiva. Este estado psicológico cria vulnerabilidade particular a narrativas populistas que prometem “drenar o pântano” ou derrubar sistema corrupto.

A propaganda digital potenciada por IA pode explorar e amplificar este cinismo através de técnicas específicas:

- Enquadramento consistentemente negativo: Apresentação seletiva de informação que reforça perceções de corrupção generalizada e incompetência institucional.

- Falsa equivalência: Apresentação de falhas menores como moralmente equivalentes a transgressões maiores, criando impressão de corrupção universal.

- Exploração de lacunas de conhecimento: Aproveitamento de compreensão limitada sobre funcionamento institucional para promover interpretações cínicas de processos normais.

O resultado é o que o cientista político Russell Muirhead chama de “democracia sem cidadãos” — sistema formalmente democrático esvaziado de participação significativa devido a desengajamento cínico generalizado.

Desafios para a Coesão Social

Além de impactos em instituições formais, a erosão de confiança estende-se ao tecido social mais amplo, minando capital social necessário para funcionamento democrático efetivo.

Estudos documentam declínio em “confiança social generalizada” — disposição para confiar em concidadãos desconhecidos — correlacionado com aumento em consumo de media algoritmicamente personalizada. Esta erosão de confiança interpessoal tem implicações profundas para capacidade de sociedades democráticas resolverem problemas coletivos que requerem cooperação além de linhas ideológicas.

Particularmente preocupante é o fenómeno que sociólogos chamam de “tribalismo epistémico” — tendência para avaliar credibilidade de informação primariamente baseada em identidade de quem a apresenta em vez de evidência ou argumentação. Estudos demonstram que utilizadores frequentes de media social algoritmicamente curada demonstram maior tendência para este tipo de raciocínio motivado por identidade.

O resultado é fragmentação social que vai além de desacordo político normal, criando o que o sociólogo Émile Durkheim chamaria de estado de “anomia” — quebra de normas sociais compartilhadas que governam interação social e comunicação. Como observou o cientista político Robert Putnam, democracia efetiva requer não apenas instituições formais, mas “capital social” — redes de confiança e reciprocidade que permitem cooperação entre cidadãos com visões divergentes.

Dissonância Cognitiva Induzida

Manipulação Sistemática da Perceção

A propaganda digital potenciada por IA pode induzir estados de dissonância cognitiva — desconforto psicológico resultante de manutenção simultânea de crenças contraditórias — através de manipulação sistemática da perceção.

Esta manipulação opera através de técnicas sofisticadas:

- Sobrecarga informacional estratégica: Inundação com volume de informação que excede capacidade de processamento cognitivo, forçando recurso a heurísticas simplificadoras vulneráveis a manipulação.

- Exploração de viés de confirmação: Apresentação seletiva de informação que confirma crenças existentes enquanto oculta informação contraditória, criando ilusão de consistência.

- Enquadramento emocional: Apresentação de informação em contextos emocionalmente carregados que dificultam processamento racional e avaliação crítica.

- Manipulação de saliência: Alteração algorítmica de quais informações parecem mais importantes ou relevantes, distorcendo perceção de prioridades.

Estudos em psicologia cognitiva demonstram que indivíduos sob dissonância cognitiva frequentemente resolvem este desconforto não através de reavaliação racional de crenças contraditórias, mas através de mecanismos psicológicos defensivos como negação seletiva, racionalização ou rejeição de fontes informativas inconvenientes.

Particularmente preocupante é o fenómeno que psicólogos chamam de “sobrecarga de dissonância” — estado onde volume de contradições cognitivas excede capacidade individual para resolução racional, levando a adoção de estratégias cognitivas simplificadoras como pensamento conspiratório ou rejeição generalizada de fontes informativas.

Exploração de Vulnerabilidades Psicológicas

A propaganda digital potenciada por IA pode identificar e explorar vulnerabilidades psicológicas específicas com precisão sem precedentes, personalizando manipulação para perfis individuais.

Sistemas contemporâneos podem inferir traços psicológicos como neuroticismo, abertura à experiência, conscienciosidade, extroversão e amabilidade através de análise comportamental digital. Estas inferências permitem exploração direcionada de vulnerabilidades específicas:

- Indivíduos com alto neuroticismo: Mais suscetíveis a conteúdo que provoca ansiedade e medo, particularmente relacionado a ameaças à segurança pessoal.

- Indivíduos com baixa abertura à experiência: Mais responsivos a apelos baseados em tradição, estabilidade e resistência a mudança.

- Indivíduos com alta conscienciosidade: Vulneráveis a manipulação baseada em apelos a dever, responsabilidade e ordem.

- Indivíduos com alta extroversão: Mais influenciados por conteúdo que enfatiza status social e aprovação de grupo.

- Indivíduos com baixa amabilidade: Particularmente responsivos a conteúdo que enfatiza competição, dominância e ameaças de grupos externos.

Além destes traços de personalidade amplos, sistemas de IA podem identificar vulnerabilidades psicológicas mais específicas como tendência para pensamento conspiratório, suscetibilidade a viés de confirmação, ou propensão para raciocínio motivado.

Particularmente preocupante é capacidade destes sistemas para identificar indivíduos em estados psicológicos temporariamente vulneráveis — períodos de transição de vida, crise pessoal, ou estresse agudo — quando suscetibilidade a manipulação é significativamente elevada.

Consequências para Autonomia Individual

A manipulação psicológica algoritmicamente otimizada levanta questões fundamentais sobre autonomia individual em contexto democrático. Se democracia pressupõe cidadãos capazes de formar julgamentos independentes baseados em deliberação racional, manipulação que contorna capacidades deliberativas representa ameaça existencial.

O filósofo político Philip Pettit argumenta que liberdade democrática requer não apenas ausência de interferência direta, mas ausência de “dominação” — capacidade de outros interferirem arbitrariamente sem accountability. Sistemas de IA que podem prever e manipular comportamento político sem transparência ou consentimento informado representam potencialmente nova forma de dominação — não através de coerção explícita, mas através de arquitetura informacional que molda impercetivelmente perceções e escolhas.

Particularmente preocupante é o fenómeno que o filósofo Harry Frankfurt chamou de “desejos de segunda ordem” — capacidade de refletir criticamente sobre e potencialmente revisar desejos e preferências de primeira ordem. Manipulação algorítmica sofisticada pode potencialmente influenciar não apenas preferências específicas, mas capacidade meta-cognitiva para avaliação crítica destas preferências.

Como observou a filósofa política Hannah Arendt, totalitarismo histórico visava não apenas controlar comportamento externo, mas colonizar consciência — criar sujeitos incapazes de pensamento independente. Embora manipulação algorítmica contemporânea opere através de mecanismos radicalmente diferentes, o risco para autonomia cognitiva evoca paralelos inquietantes.

Implicações para Democracias Contemporâneas

Os riscos psicológicos e democráticos discutidos representam desafios fundamentais para sistemas democráticos contemporâneos. Democracia pressupõe cidadãos capazes de formar julgamentos autónomos baseados em informação compartilhada, deliberar racionalmente sobre questões complexas, e responsabilizar líderes através de processos eleitorais informados.

A convergência entre propaganda digital e inteligência artificial ameaça estes fundamentos através de múltiplos mecanismos: fragmentando espaço informacional compartilhado, minando capacidade para deliberação racional, erodindo confiança necessária para cooperação democrática, e potencialmente comprometendo autonomia cognitiva necessária para autodeterminação democrática.

Estas ameaças não representam simplesmente evolução de desafios democráticos familiares, mas transformação qualitativa no ambiente informacional que sustenta governança democrática. Como observou o cientista político Francis Fukuyama, “a questão central para democracias contemporâneas não é simplesmente como regular plataformas digitais específicas, mas como preservar possibilidade de realidade epistémica compartilhada necessária para deliberação democrática.”

Responder a estes desafios requer não apenas inovações técnicas ou regulatórias, mas renovação mais fundamental de instituições e práticas democráticas para era digital. A próxima secção explorará estratégias potenciais para construir resiliência democrática face a estas novas formas de manipulação psicológica.

V. Resiliência Cívica e Literacia Mediática

Face aos desafios psicológicos e democráticos apresentados pela convergência entre propaganda digital e inteligência artificial, torna-se imperativo desenvolver estratégias abrangentes de resiliência cívica. Estas estratégias devem operar em múltiplos níveis — desde educação individual até regulação sistémica — para fortalecer capacidades democráticas na era digital.

Educação para Literacia Digital

Programas Educativos em Escolas e Universidades

A educação formal representa linha de defesa fundamental contra manipulação informacional. Sistemas educativos em democracias contemporâneas devem adaptar-se urgentemente para equipar cidadãos com competências necessárias para navegação crítica do ecossistema informacional digital.

Programas educativos eficazes para literacia digital devem integrar múltiplos componentes:

- Compreensão técnica básica: Conhecimento fundamental sobre funcionamento de algoritmos, redes sociais e sistemas de IA, permitindo que cidadãos compreendam mecanismos subjacentes à curadoria de conteúdo digital.

- Competências de verificação: Capacidade para avaliar criticamente fontes, verificar afirmações factuais, e identificar manipulação visual e textual, incluindo conteúdo gerado por IA.

- Consciência psicológica: Compreensão de vieses cognitivos e vulnerabilidades psicológicas exploradas por propaganda digital, permitindo meta-cognição sobre próprios processos de formação de crenças.

- Ética digital: Desenvolvimento de estruturas normativas para comportamento online responsável, incluindo compreensão de consequências sociais mais amplas de partilha de desinformação.

Iniciativas promissoras nesta direção incluem o programa finlandês “Elementos de IA”, curso online gratuito sobre fundamentos de inteligência artificial disponibilizado para toda população; o currículo de literacia mediática da Estónia, que integra competências de verificação digital em todas disciplinas desde o ensino básico; e a iniciativa portuguesa “SeguraNet”, que desenvolve competências de cidadania digital em contexto escolar.

Particularmente importante é integração destas competências transversalmente no currículo, em vez de isolá-las em disciplinas específicas. Como demonstrado pelo programa finlandês, literacia digital é mais eficazmente desenvolvida quando incorporada em contextos disciplinares diversos — desde história (avaliando fontes primárias) até ciências (distinguindo evidência de opinião).

Ferramentas para Identificação de Manipulação

Além de educação formal, cidadãos necessitam ferramentas práticas para identificação de manipulação digital no quotidiano. Desenvolvimentos promissores nesta área incluem:

- Verificadores de autenticidade: Aplicações como Truepic e Content Authenticity Initiative que utilizam criptografia para verificar proveniência e integridade de conteúdo digital, permitindo distinguir entre material original e manipulado.

- Detetores de deepfake: Ferramentas como Sensity e Deeptrace que utilizam IA para identificar manipulações audiovisuais, analisando inconsistências imperceptíveis para observação humana.

- Extensões de navegador: Ferramentas como NewsGuard e SurfSafe que fornecem avaliações em tempo real sobre credibilidade de fontes e potencial desinformação durante navegação normal.

- Plataformas colaborativas de verificação: Iniciativas como Verificado (Portugal) e Comprova (Brasil) que mobilizam jornalistas e especialistas para verificação colaborativa de conteúdo viral, disponibilizando resultados em formato acessível.

Significativamente, estas ferramentas são mais eficazes quando combinadas com educação sobre seus princípios subjacentes. Estudos demonstram que utilizadores que compreendem como ferramentas de verificação funcionam demonstram maior capacidade para aplicar princípios similares mesmo sem assistência tecnológica.

Desenvolvimento de Pensamento Crítico

Fundamentalmente, resiliência contra manipulação informacional requer desenvolvimento de pensamento crítico — capacidade para análise independente, avaliação de evidência, e reconhecimento de falácias lógicas e manipulação emocional.

Abordagens pedagógicas eficazes para desenvolvimento de pensamento crítico incluem:

- Aprendizagem baseada em investigação: Metodologias que posicionam estudantes como investigadores ativos em vez de recetores passivos de informação, desenvolvendo capacidades para formulação de questões e avaliação de evidência.

- Pedagogia socrática: Abordagens dialógicas que enfatizam questionamento sistemático e exame de pressupostos subjacentes, desenvolvendo hábito de interrogação crítica.

- Análise de estudos de caso: Exame detalhado de exemplos históricos e contemporâneos de manipulação informacional, desenvolvendo capacidade para reconhecer padrões e técnicas recorrentes.

- Metacognição: Práticas que promovem consciência e reflexão sobre próprios processos cognitivos, permitindo identificação de vieses pessoais e vulnerabilidades a manipulação.

Estudos longitudinais demonstram que indivíduos com formação explícita em pensamento crítico demonstram significativamente maior resiliência contra desinformação e manipulação algorítmica, mesmo quando expostos a técnicas sofisticadas de persuasão.

Como observou a filósofa Martha Nussbaum, “democracia necessita cidadãos que possam pensar por si mesmos em vez de simplesmente deferir à autoridade… que possam raciocinar juntos sobre suas escolhas em vez de simplesmente negociar suas reivindicações” — capacidades que tornam-se simultaneamente mais cruciais e mais desafiantes na era da propaganda algorítmica.

Transparência Algorítmica

Propostas de Regulação de Algoritmos

A opacidade de algoritmos que moldam crescentemente ambiente informacional representa desafio fundamental para accountability democrática. Propostas emergentes para transparência algorítmica incluem:

- Auditorias algorítmicas obrigatórias: Requisitos para avaliação independente de algoritmos com impacto significativo no discurso público, analisando potenciais vieses e efeitos sistémicos.

- Divulgação de métricas de otimização: Obrigação para plataformas digitais revelarem objetivos fundamentais para os quais seus algoritmos são otimizados (engajamento, tempo de utilização, etc.).

- Registos de transparência: Sistemas que documentam mudanças significativas em algoritmos com impacto público, permitindo rastreabilidade e accountability ao longo do tempo.

- Requisitos de explicabilidade: Obrigação para sistemas algorítmicos fornecerem explicações compreensíveis para decisões com impacto significativo em direitos ou oportunidades individuais.

O Regulamento de Inteligência Artificial da União Europeia (AI Act) representa avanço significativo nesta direção, estabelecendo requisitos de transparência e avaliação de risco para sistemas de IA considerados de “alto risco”, incluindo aqueles que influenciam formação de opinião pública.

Similarmente, a Lei de Serviços Digitais (DSA) europeia introduz requisitos para plataformas explicarem funcionamento de sistemas de recomendação e oferecerem alternativas não personalizadas, representando passo importante para devolver agência a utilizadores sobre seu ambiente informacional.

Direito à Explicação de Decisões Algorítmicas

Além de transparência sistémica, cidadãos necessitam direitos individuais relacionados a decisões algorítmicas que os afetam. O conceito de “direito à explicação” — direito de indivíduos receberem explicação compreensível para decisões algorítmicas significativas — emerge como princípio fundamental para governança democrática de IA.

Este princípio manifesta-se em múltiplos desenvolvimentos regulatórios:

- Regulamento Geral de Proteção de Dados (RGPD): Estabelece direito limitado à explicação para decisões automatizadas com efeitos jurídicos ou similarmente significativos.

- Lei de Algoritmos de Nova Iorque: Requer auditorias de viés para algoritmos utilizados em decisões municipais e estabelece mecanismos para contestação de decisões algorítmicas.

- Carta Canadiana de Direitos Digitais: Propõe direito explícito à explicação para decisões automatizadas que afetam direitos ou interesses significativos.

Significativamente, estas proteções estão gradualmente expandindo de decisões administrativas formais (aprovação de crédito, contratação) para incluir sistemas que moldam ambiente informacional e discurso público — reconhecimento que curadoria algorítmica de informação representa forma de “decisão” com impacto significativo em direitos democráticos fundamentais.

Auditorias Independentes de Sistemas de IA

Complementando requisitos regulatórios, auditorias independentes emergem como mecanismo crucial para avaliação de impacto democrático de sistemas algorítmicos. Estas auditorias podem assumir múltiplas formas:

- Auditorias académicas: Investigadores independentes avaliam impactos de sistemas algorítmicos através de metodologias como “sock puppet auditing” (criação de contas simuladas para testar comportamento algorítmico) e análise de dados disponibilizados por plataformas.

- Auditorias jornalísticas: Organizações mediáticas conduzem investigações sistemáticas sobre efeitos de algoritmos, frequentemente utilizando metodologias participativas envolvendo utilizadores reais.

- Auditorias regulatórias: Agências governamentais com expertise técnica avaliam conformidade de sistemas algorítmicos com requisitos legais e padrões éticos.

- Auditorias da sociedade civil: Organizações não-governamentais desenvolvem metodologias para avaliação independente de impactos algorítmicos, frequentemente focando em populações vulneráveis ou subrepresentadas.

Iniciativas como Algorithm Watch na Europa e AI Now Institute nos Estados Unidos exemplificam abordagem da sociedade civil para auditoria algorítmica, desenvolvendo metodologias para avaliação sistemática de impactos sociais e políticos de sistemas de IA.

Particularmente promissora é emergência de estruturas padronizadas para documentação de sistemas de IA, como “Model Cards” e “Datasheets for Datasets”, que facilitam avaliação independente através de divulgação estruturada de características, limitações e potenciais riscos de sistemas algorítmicos.

Regulação Ética de IA

Marcos Regulatórios Emergentes

A regulação ética de inteligência artificial em contexto democrático está evoluindo rapidamente, com múltiplas abordagens emergindo globalmente:

- Abordagem baseada em risco da UE: O AI Act europeu estabelece requisitos proporcionais ao nível de risco apresentado por diferentes aplicações de IA, com restrições mais rigorosas para sistemas considerados de “alto risco” para direitos fundamentais.

- Abordagem setorial dos EUA: Regulação focada em aplicações específicas de IA em setores sensíveis (saúde, finanças, educação) através de agências especializadas, complementada por diretrizes voluntárias.

- Abordagem centralizada da China: Regulação abrangente focada primariamente em alinhamento de sistemas de IA com objetivos estatais e estabilidade social, com ênfase em controlo de conteúdo algorítmico.

- Abordagens híbridas: Países como Canadá, Japão e Singapura desenvolvem combinações de regulação formal em áreas de alto risco com estruturas de governança colaborativa envolvendo múltiplos stakeholders.

Particularmente relevante para propaganda digital é emergência de regulações específicas para sistemas algorítmicos que influenciam formação de opinião pública. O Código de Prática sobre Desinformação da UE, por exemplo, estabelece compromissos para plataformas digitais reduzirem amplificação algorítmica de desinformação e aumentarem transparência sobre funcionamento de sistemas de recomendação.

Similarmente, a Lei de Serviços Digitais europeia introduz obrigações específicas para “plataformas muito grandes” relacionadas a avaliação de riscos sistémicos, incluindo potencial para manipulação algorítmica do discurso público.

Responsabilidade de Plataformas Digitais

Além de regulação formal, emerge reconhecimento crescente da responsabilidade ética de plataformas digitais como infraestruturas fundamentais para discurso democrático contemporâneo. Esta responsabilidade manifesta-se em múltiplas dimensões:

- Dever de cuidado: Obrigação de plataformas considerarem impactos sociais e democráticos de decisões algorítmicas, não apenas métricas de engajamento ou lucro.

- Transparência proativa: Responsabilidade para divulgação voluntária de informações relevantes sobre funcionamento e impactos de sistemas algorítmicos.

- Design responsável: Obrigação de incorporar considerações éticas e democráticas desde estágios iniciais de desenvolvimento de sistemas algorítmicos.

- Mitigação de danos: Responsabilidade para identificar e mitigar proativamente potenciais danos resultantes de sistemas algorítmicos, particularmente para grupos vulneráveis.

Iniciativas como Santa Clara Principles on Transparency and Accountability in Content Moderation e Partnership on AI representam esforços da indústria para articular e implementar padrões éticos para governança algorítmica, embora frequentemente criticados por insuficiência face à escala dos desafios.

Particularmente significativa é emergência de estruturas de “responsabilidade algorítmica” que vão além de conformidade legal para articular obrigações éticas mais amplas de plataformas digitais como infraestruturas essenciais para deliberação democrática contemporânea.

Equilíbrio entre Inovação e Proteção Democrática

Um desafio central para regulação ética de IA é balancear necessidade de proteção democrática com benefícios de inovação tecnológica. Abordagens promissoras para este equilíbrio incluem:

- Regulação baseada em princípios: Estabelecimento de princípios fundamentais e objetivos regulatórios em vez de prescrições técnicas específicas, permitindo flexibilidade implementacional.

- Sandboxes regulatórias: Ambientes controlados onde inovações podem ser testadas sob supervisão regulatória, permitindo avaliação de impactos antes de implementação ampla.

- Regulação adaptativa: Estruturas regulatórias que evoluem baseadas em evidência empírica sobre impactos, incorporando mecanismos para revisão e ajuste periódicos.

- Co-regulação: Abordagens colaborativas envolvendo reguladores, indústria, academia e sociedade civil no desenvolvimento e implementação de padrões éticos.

O conceito de “inovação responsável” emerge como princípio orientador, enfatizando que verdadeira inovação não se limita a avanço tecnológico, mas inclui desenvolvimento de estruturas sociais, éticas e governamentais necessárias para integração benéfica de tecnologias em sociedades democráticas.

Como articulado pela investigadora Sheila Jasanoff, o desafio fundamental é desenvolver “tecnologias de humildade” — abordagens que reconhecem limites de previsibilidade e controlo em sistemas sociotécnicos complexos, e incorporam mecanismos para aprendizagem contínua e ajuste baseado em impactos observados.

Fortalecimento do Jornalismo Independente

Papel do Jornalismo na Era da Desinformação

O jornalismo profissional independente emerge como contrapeso crucial à propaganda algorítmica, desempenhando múltiplas funções democráticas essenciais:

- Verificação factual: Estabelecimento de base factual compartilhada através de metodologias jornalísticas de verificação, contextualização e correção.

- Curadoria editorial: Priorização de informação baseada em relevância pública e significância democrática, em contraste com otimização algorítmica para engajamento.

- Investigação sistemática: Exposição de manipulação informacional e seus perpetradores através de jornalismo investigativo sustentado.

- Contextualização: Fornecimento de enquadramento histórico, social e político necessário para interpretação significativa de eventos e tendências.

Estudos demonstram correlação significativa entre presença de jornalismo local robusto e múltiplos indicadores de saúde democrática, incluindo participação eleitoral, accountability governamental e confiança institucional. Inversamente, “desertos noticiosos” — comunidades sem cobertura jornalística local — demonstram maior vulnerabilidade a desinformação e manipulação informacional.

Particularmente crucial é papel do jornalismo como “instituição intermediária” que traduz entre sistemas especializados (ciência, direito, governança) e público geral, função que algoritmos de recomendação frequentemente contornam ao conectar diretamente fontes primárias a audiências sem contextualização necessária.

Modelos Sustentáveis para Media de Qualidade

O desafio fundamental para jornalismo contemporâneo é desenvolvimento de modelos económicos sustentáveis face à disrupção digital. Abordagens promissoras incluem: